[Компьютерное железо, История IT, Старое железо, Видеокарты, Настольные компьютеры] Графические войны #2: красно-зеленая эпоха

Автор

Сообщение

news_bot ®

Стаж: 8 лет

Сообщений: 27286

Часть 2Часть 12000-2006. Падение 3Dfx. Начало двухстороннего противостояния2000 год - Эпоха слияний и поглощений в индустрии.Начало нового тысячелетия ознаменовало большие перемены на рынке видеокарт. Многие компании профессионального сегмента готовились покидать отрасль – после ухода ixMicro свои последние продукты представили NEC (TE5) и Hewlett-Packard (VISUALIZE FX10). А Evans & Sutherland продала своё графическое подразделение RealVision, переключившись на создание купольных систем для планетариев.На мейнстрим-рынке в феврале 2000 года ATi приобрела ArtX Inc за $400 млн в акциях. Компания разрабатывала новый графический чип для будущей Nintendo GameCube (известный как Project Dolphin, а позже - Flipper). Такая покупка позволила ATi значительно расширить своё портфолио, заявив о себе на новом рынке.3Dfx, сократив штат на 20%, приобрела компанию Gigapixel за $186 млн, получив в свое распоряжение проприетарную технологию мозаичного рендеринга, тогда как S3 и NVidia завершили судебные разбирательства заключением нового партнерского соглашения на ближайшие семь лет.Наиболее важным новым игроком на рынке в тот период стала VIA – компания, купившая в недавнем прошлом Number Nine и многострадальную S3. Реструктурировав бизнес, VIA объединила S3 с AIB-производителем Diamond Multimedia – сумма сделки составила $165 млн в эквиваленте ценных бумаг. Независимым осталось лишь профессиональное подразделение DM FireGL – выйдя из состава компании и реорганизовавшись как SONICBlue, компания в итоге стала частью ATi в марте 2001 за скромные $10 млн. Активной была и 3DLabs, выкупившая Intense3D у Intergraph в апреле 2000 года. В результате рынок увидел первую серьезную консолидацию, прямо намекнувшую на возможное будущее рынка в лице противостояния нескольких ключевых игроков. И 3Dfx стремительно приближалась к числу тех, кто уже стал частью минувшей эпохи.

3Dfx – Последние попытки и уход в закатЧереда неудач на графическом рынке, импульсивное руководство и непонимание критической важности создания новой архитектуры привели 3Dfx к печальному итогу – несмотря на неплохие продажи, компания несла убытки уже несколько лет, и отчаянно нуждалась в продукте, способном перевернуть рынок также, как это сделала оригинальная Voodoo. Долгожданная Voodoo 5500, вышедшая в июле 2000 года, показала себя неплохо, выступая на уровне с GeForce 256 DDR и вырываясь вперед при игре в высоких разрешениях, но революции не произошло.

3Dfx Voodoo 5 5500 Архитектурные преимущества, обеспечившие успех Voodoo, во многом крылись в высокой «сырой» производительности – вычислительной мощности, способной перекрыть многие возможные недостатки. С Voodoo 5500 на смену этих особенностей пришли другие, менее очевидные преимущества – например, полноэкранное сглаживание. 3Dfx использовала технологию Т-буфера вместо уже классической трансформации и освещения (T&L), объединяя несколько промежуточных фреймов в единый кадр. Такая технология обеспечивала мягкий эффект размытия и лучшую плавность анимации на высоких кадровых частотах.Извините, данный ресурс не поддреживается. :( Именно эта технология легла в основу множества графических особенностей, получивших повсеместное использование. Мягкие тени, motion blur, глубина поля, отражения – всё это было построено на базе того, что в последний год создавала 3Dfx, значительно опередив своё время. Последним релизом легендарной компании стала Voodoo 4500, вышедшая на рынок в октябре 2000 года.

3Dfx Voodoo4 4500Из-за задержек (карта ожидалась еще летом в качестве конкурента для NVidia TNT 2) новинке от 3Dfx пришлось конкурировать уже с могучей GeForce 256 DDR, а также будущими GeForce 2 GTS и ATi Radeon DDR. Из-за финансовых трудностей другие линейки 3Dfx (Voodoo 4200 и 4800) так и не увидели свет, сохранившись лишь в виде прототипов.14 ноября 2000 года 3Dfx объявила о прекращении выпуска своих брендовых видеокарт.

Последним гвоздем в крышку гроба стали новости о том, что отсутствие обратного сигнала по линии 3.3V на новейшей платформе Pentium IV сделает невозможной работу адаптеров Voodoo на новом поколении систем Intel.Паническая покупка SGI и отчаянное желание наладить производство чипов собственными силами привели 3Dfx к банкротству, в результате которого NVidia приобрела всё портфолио конкурента за смехотворные $70 млн, а также миллиона долларов в формате своих акций. Все проприетарные разработки и технологии 3Dfx стали частью портфолио NVidia, и в будущем повсеместно применялись в видеокартах новых поколений. Легенда гласит, что озлобленные инженеры 3Dfx после перехода в NVidia решили отомстить компании, и выпустили печально известные FX 5700 и FX 5800 – худшие видеокарты в истории компании Дженсена Хуанга. Впрочем, это могла быть просто старая байка.Начало эпохи ATi vs NVidiaКогда многие геймеры все еще ожидали выхода Voodoo 5, ATi анонсировала Radeon DDR – «самый мощный видеочип, который когда-либо выпускался для ПК-рынка».

ATi Radeon 7200 DDRПредварительные обзоры видеокарты уже появились в прессе 25 апреля, но менее чем через сутки после анонса свой ответ на «самый передовой чип» дала NVidia, анонсировав GeForce 2 GTS (GigaTexel Shader). Новинка включала собственную версию архитектуры Pixel Tapestry в виде NVidia Shading Rasterizer, включающей множество аппаратных технологий, таких как зеркальное выделение, объемные взрывы, рефракцию, симуляцию волн, вертексное смешение, объемные тени, бамп-маппинг и elevation-маппинг, применяемый к каждому пикселю на экране с помощью аппаратных инструкций.

NVidia GeForce 2 GTSОбширный список новшеств NVidia задумывала реализовать еще в GeForce 256, но из-за аппаратных проблем они были отключены на этапе производства. Вместе с вышесказанным, NVidia реализовала собственную версию Charisma Engine от ATi, - движка для выполнения цикла операций трансформации, освещения и отсечения ресурсами GPU. Тем не менее, в этом отношении ATi пошла дальше c технологией vertex skinning, позволяющей обеспечить более плавное движение полигонов, а также интерполяции ключевого кадра, в котором разработчики могли задать начальную и конечную точку формирования полигональной сетки, доверяя Charisma Engine достраивать комбинацию из промежуточных шагов.ATI Radeon DDR вышла на рынок в августе 2000 года. Видеокарта обеспечивала невероятную производительность T&L-алгоритмов, а также поддерживала некоторые возможности новейшего API DirectX 8.0, наряду с GeForce 2 GTS начав эру DVI, интегрировав контроллер непосредственно в видеочип. Тем не менее, DVI еще не был так популярен среди простых геймеров, и поэтому карты с новейшим разъемом чаще уходили на ОЕМ-рынок, тогда как в ретейле куда чаще попадались платы с коннекторами VIVO.У Radeon DDR были и недостатки – частоты чипа и памяти оказались ниже ожидаемых, а в 16-битном цвете возникали артефакты на экране. Драйвера на старте продаж были далеки от оптимальных, но даже они не помешали Radeon DDR выйти в лидеры в разрешениях выше 1024-768 при 32-битном цвете. Карта с 64 Мб на борту продавалась за $399, и отлично конкурировала с GeForce 2 GTS по схожей цене – отрыв в производительности в среднем составлял 15% в пользу ATi, что позволило канадской компании выйти в лидеры, завоевав бОльшую долю мейнстрим-рынка.Однако это не значит, что дела у NVidia шли плохо – компания показывала стабильный рост, и расширяла своё присутствие в различных сегментах рынка. В июне была выпущена упрощенная версия видеокарты GeForce 2 с припиской MX, а в августе свет увидела заряженная Ultra-версия, вернувшая NVidia первое место по производительности в играх – правда, и стоила такая карта уже $499.

NVidia GeForce 2 UltraMX-версия чипа получила и профессиональный вариант в виде Quadro 2, а GeForce2 Go удовлетворила спрос на передовую графику в мобильном сегменте рынка.PowerVR KYRO и KYRO II – Конкуренция в кавычкахВ ноябре 2000 года, когда 3Dfx уже готовилась к процедуре банкротства, компания Imagination Tech (бывшая VideoLogic) совместно с STMicro решила попытать счастья на объемном рынке бюджетных видеокарт с PowerVR KYRO.

PowerVR KYROНовинка стоила в промежутке от $80 до $110, и предлагала неплохую производительность в играх при разрешении 1024х768 (32 бита) и ниже. К сожалению, победному шествию адаптера по рынку помешала NVidia, выпустившая GeForce 2 MX за те же самые $110.Но Imagination Tech не сдалась, и выпустила KYRO II в апреле 2001 года. Передовой 180-нм техпроцесс STMicro вкупе с подросшими частотами ядра и памяти мог был обеспечить безоговорочную победу, но NVidia ответила снижением цены MX на 40% (переименовав карту в MX200), а на её прежнее место по той же цене вышла MX400 с серьезно «заряженными» частотами.Карты PowerVR не имели аппаратной поддержки мозаичного рендеринга, из-за чего сильно буксовали на фоне конкурентов в новых проектах. STMicro закрыла своё графическое подразделение в 2002 году, тогда как Imagination Tech перешла в мобильный бизнес, выпуская SoC-решения на основе ARM-процессоров для смартфонов и первых планшетных компьютеров.Такие компании, как Matrox и VIA/S3 более не горели желанием включаться в гонку за производительностью на ПК, сосредоточив усилия на ОЕМ-рынках.NVidia GeForce 3 – нарастающее преимуществоНа волне успехов GeForce 2 NVidia в феврале 2001 года анонсировала GeForce 3 по цене от $339 до $449. Главным преимуществом новинки была доселе невиданная производительность в разрешении 1600х1200 с использованием полноэкранного сглаживания.

NVidia GeForce 3Как это часто бывает, первые версии драйверов не отличались стабильностью – особенно пострадали игры, использующие OpenGL. В числе программных новинок NVidia реализовала поддержку DirectX 8, мультисэмплинг, кенконксное сглаживание (которое, по сути, работало как MSAA 2х с добавлением блюра на этапе постпроцессинга), восьмикратную анизотропную фильтрацию, а также первую аппаратную возможность её совмещения с трилинейной в едином механизме рендера. Программируемые вертексные шейдеры позволили GeForce 3 лучше контролировать движение полигональных сеток и в итоге обеспечили повышение плавности анимации.Была реализована и LMA (Lightspeed Memory Architechture) – аналог HyperZ, фильтрующий обработку пикселей, не попадающих в поле зрения (отсечение Z-окклюции), а также обеспечивающий компрессию и декомпрессию данных для оптимизации пропускной способности шины (Z- компрессия).Последней особенностью GeForce 3 стала реализация алгоритмов балансировщика загрузки, ставших частью Crossbar Memory Controller – сложной системы из четырех независимых контроллеров памяти, внедренных для более эффективного управления буфером.Позже портфолио NVidia пополнил тот самый чип NV2A, разработанный на основе GeForce 2 (с рядом особенностей GeForce 4) для консоли XBox. Контролируя 31% рынка видеокарт в 2001 году, NVidia стала законодателем мод, а уже следом шли Intel (26%) и ATi (17%).Radeon 8500 – Пафос, шок, легкое разочарованиеКогда линейка NVidia уже включала целое семейство продуктов на базе GeForce 3, ATi в срочном порядке организовала вывод на рынок Radeon 8500 – достойного ответа лидеру рынка, произведенного по тем же 150 нм TSMC (как и чип NV20 GeForce 3). После официального анонса геймеры со всего мира с нетерпением ждали выхода канадской новинки – тогда сам Джон Кармак уверенно заявлял, что в Doom 3 8500 окажется вдвое быстрее GeForce 3.

ATi Radeon 8500Рекламная кампания была громкой, и во многом напоминала дерзкий маркетинг 3Dfx – «самая производительная видеокарта в мире» ворвалась на прилавки в октябре 2001, и сразу же сорвала розовые очки поклонников: производительность «самой производительной карты» оказалась на уровне GeForce 3 Ti 200 – далеко не передовой модели NVidia. Драйвера оставляли желать лучшего, а технология сглаживания Smoothvision и вовсе не работала – первая волна обзоров была разгромной, но уже к зимним каникулам большинство изданий выпустили новые материалы, признав, что проблемы с драйверами были решены, а итоговая производительность Radeon 8500 расположилась между Ti 200 и стандартной GF3.На несмотря на то, что первые строчки бенчмарков остались за NVidia, Radeon 8500 обладала рядом бесспорных преимуществ. Более высокое качество изображения в 2D-режиме, плавное воспроизведение видео и высокая производительность со сглаживанием предлагались поклонникам по демократичной цене, составляя достойную конкуренцию одноклассникам NVidia.Закончив год с убытками в $54 миллиона, ATi сосредоточила силы на разработке новой архитектуры и начала продавать лицензии на производство партнерских видеокарт.Одним из самых необычных продуктов в портфолио ATi того времени стала Set-Top-Wonder Xilleon – инженерная платформа, включающая полноформатную плату с интегрированным процессором, видео и аудио-чипами и системой ввода-вывода, снабженной нужными разъемами для использования в первых цифровых ресиверах для домашнего ТВ.

Set-Top-Wonder XilleonДля разработки платформы ATi летом 2002 года приобрела компанию NxtWave Communications за $20 млн., занимавшуюся технологиями обработки цифрового видеосигнала, а также разработкой ПО для ресиверов и спутниковых тарелок.GeForce 4 – Фальшивые бюджетники и настоящие ТитаныУже выработав определенный календарный цикл для своих релизов, NVidia представила линейку GeForce 4 в феврале 2002 года.

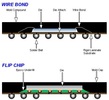

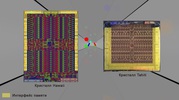

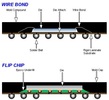

NVidia GeForce 4 Ti 4600Она получилась достаточно объемной, и включала три карты MX-серии, три мобильных варианта, построенных на MX-чипах, а также два премиальных адаптера серии Titanium (Ti 4400 и Ti 4600). Хотя новая серия NVidia была готова к выходу в продажу еще в ноябре, в компании не хотели подрывать рекордные продажи предыдущей линейки во время Черной Пятницы и новогодних каникул. Представьте себе лицо геймера, купившего GeForce 3 за неделю до выхода нового поколения – вместо недели Дженсен Хуанг дал целых три месяца счастья тем, кто решил хорошенько потратиться в праздники.Именно в линейке GeForce 4 NVidia сознательно пошла на ребрендинг для сокращения затрат – под удар попал бюджетный сегмент, где видеокарты серии MX по факту не были новинками, а принадлежали всё той же линейке GeForce 2. Вместо новейших технологий счастливчики, заплатившие за новинку $179, получали поддержку DirectX 7.0/7.1 и обновленный кодек MPEG2. Зато любители покупать самое лучшее сорвали джекпот – карты серии Titanium (или сокращено Ti) серьезно подняли планку производительности, обеспечив более чем 50% рост в сравнение с GF3 Ti 500. Ti 4600 мгновенно стала самой желанной видеокартой на рынке, возглавив всевозможные бенчмарки популярных «железных» новинок, а Ti 4400 за $199 получила лестный титул «лучшая видеокарта по соотношению цена-производительность». Radeon 8500 оказалась на обочине праздника NVidia, безнадежно отставшая по всем фронтам.А потом ATi перестала играть в бирюльки и выдала Radeon 9700 Pro, напомнив NVidia, что такое настоящий прогресс.Radeon 9700 Pro – Графический переворотРазработанный командой, некогда составлявшей костяк ArtX, чип R300 оказался громом среди ясного неба. Он первым на рынке получил полную поддержку DirectX 9.0, первым обеспечил шейдеры версии 2.0, как пиксельные, так и вертексные. Уступая лишь картам серии S3 Xabre 80/200/400, R300 вторым на рынке перешел на восьмиканальную шину AGP и первым изготавливался по 150 нм технологии с применением производственного метода flip-chip, когда контактные площадки кристалла GPU располагаются непосредственно на нем, обеспечивая соединение с контактами платы напрямую, без использования внешних проволочных проводников.

Как и NVidia, ATi готовила целую линейку карт – в октябре свет увидела обычная версия 9700 за $299 (для тех, кто не был готов расстаться с $399), а экономные геймеры получали на выбор 9500 Pro ($199) или обычную 9500 ($179) для игр и других задач. Не забыли в ATi и о профессиональном рынке – эти нужды удовлетворяли модели FireGL Z1/X1 за $550 и $950. Последней в изначальной линейке стала All-In-Wonder 9700 Pro за $449, представленная уже в декабре.

ATi Radeon 9700 ProКарты вышли прорывными, но продажи ATi всё равно пострадали – уже по вине энтузиастов, открывших возможности модификации доступных моделей в более дорогостоящие. Так референсную модель 9500 можно было превратить в 9700, а 9800 Pro волшебным образом могла стать «заряженной» 9800 XT. Такие перевоплощения становились возможным благодаря любительскому патчу драйвера видеокарты для распознавания модификации. Само же превращение осуществлялось или через работу с резистором, либо с помощью обычного карандаша, немного пошаманив с контроллером напряжений GPU и видеопамяти.

Особо увлеченные энтузиасты превращали 9800 в профессиональную FireGL X2, а бюджетную 9800 SE с помощью модификации драйвера можно было превратить во флагманскую 9800 Pro, стоившую почти вдвое больше.Как и всегда, одной лишь графикой для ПК-рынка дело не ограничилось, и ATi представила множество решений в сегменте встроенной графики и чипсетов, как для AMD, так и для Intel. A3/IGP 320 предназначалась для платформ первых, RS200/IGP 330 & 340 – для вторых. Мобильный сегмент тоже не был оставлен в стороне – для решений AMD была выпущена U1/IGP 320M, а Intel получила чип RS200M для своих Pentium4-M. Все чипы интегрированной графики работали в связке с южными мостами производства ATi – чаще всего это были IXP200 или 250.SiS Xabre – Когда пора на выходВ разгар противостояния GeForce 4 и R300 компания SiS выпустила на рынок линейку видеокарт Xabre. Новинки оказались нелепыми – высокие цены и отсутствие аппаратной поддержки вертексных шейдеров ставили под вопрос смысл такого релиза. Разработчикам игр ничего не оставалось, кроме включения в драйвера программной эмуляции сложного алгоритма, чтобы хотя бы как-то удерживать на плаву слабые решения от SiS.

Xabre 400Фирменной разработкой SiS в серии Xabre стала технология Turbo Texturing. Резко снижая качество текстур, игрок мог увеличить производительность в игре, но из-за отсутствия возможности сглаживая замыленной картинки преимущества новой технологии никто не увидел.Нетрудно догадаться, что Xabre стала последней линейкой под брендом SiS – графической подразделение компании отделилось под брендом XGI, а сама SiS стала частью Trident Graphics в июне 2002 года.NVidia FX – Зеленый Фуфыкс на потеху 3DfxНовый виток развития графики NVidia пришелся на серию FX, представленную 27 января 2003 года с печально известной FX 5800 по прозвищу Dustbuster и её «заряженной» версии FX 5800 Ultra.

NVidia GeForce FX 5800 UltraНа фоне нового чемпиона в лице Radeon 9700 Pro (и его младшего брата 9700) новинки не внушали энтузиазма – карты серии FX были очень громкими, хуже справлялись с полноэкранным сглаживанием и анизотропной фильтрацией, и уступали флагманам ATi в общем зачете. Прошлогодняя линейка канадцев настолько превосходила конкурентов, что даже обычная 9700, вышедшая за 5 месяцев до премьеры линейки FX, оказалась быстрее хвалебной Ultra (хотя стоила при этом на $100 дешевле - $299 против $399).Новый графический чип NV30 должен был выйти в августе 2003-го и исправить положение, но высокий процент брака в кремниевых пластинах 130 нм техпроцесса non-K TSMC заставили NVidia отложить релиз, сосредоточив усилия на разработке NV2A для консоли Xbox (известному как SandStorm), а также ряде новых чипсетов для материнских плат.Понимая, что дальнейшие задержки – непозволительная роскошь, NVidia в срочном порядке перевела производство на фабрики IBM, использовав 130 нм техпроцесс на основе флюросиликатного стекла. Через 3.5 месяца после премьеры разочарования в лице FX5800, NVidia представила работу над ошибками – карты FX 5900 и FX5900 Ultra на базе доработанного чипа NV35.

NVidia GeForce FX 5900 UltraНовый набор драйверов Detonator FX (сразу чувствуется пафос 3Dfx!) значительно улучшил работу со сглаживанием и анизотропной фильтрацией, почти догнав ATi в этом отношении, но что куда важнее, 5900 удалось сместить 9800 Pro с пьедестала самой производительной видеокарты – правда, по цене в $499. Злить канадцев подобной провокацией было ошибкой.Radeon 9800 XT – Твоё место под номером 2Несмотря на то, что 9800 Pro недолго пробыла в качестве лидера, именно с неё началось обновление линейки ATi – доработанный чип R350 получил поддержку Hyper-Z-кэширования и технологии сжатия инструкций.

ATi Radeon 9800 ProПодготовила ATi и другие версии своего чипа для бюджетных категорий видеокарт – RV350 и RV280. Первый из них лег в основу Radeon 9600, и использовал передовой техпроцесс TSMC non-K 130 нм, тогда как второй был обновленной версией RV250 с поддержкой восьмиканальной шины AGP, и лег в основу Radeon 9200.Важным вкладом в общие успехи ATi стали два контракта на разработку видеочипов – один из них предназначался для Nintendo Wii, другой лег в основу XBox 360. Партнерство с японской компанией было особенно важным стратегически, так как позволило заявить о себе на других, ранее недоступных рынках.В стремлении вернуть утраченное лидерство ATI в сентябре 2002 года представила 9800 XT.

ATi Radeon 9800 XTДрайвера впервые за долгое время работали безупречно, а игровые новинки с поддержкой DirectX 9.0 демонстрировали прекрасную производительность – канадцы снова заняли первую строчку во многих бенчмарках, закончив год максимально удачным образом. 9700 Pro получила признание мейнстрим-рынка, тогда как NVidia досталось лишь место «лучшего продукта в категории цена-производительность» - его получила FX 5200.2002 год закончился для ATi прибылью в $35.2 миллиона – во многом благодаря большой марже с продаж 9800 и 9600. NVidia покорила бюджетный сегмент, заняв 75% рынка благодаря популярности FX 5200.XGI Volari и S3 DeltaChrome – Последние из могиканБывшее подразделение SiS, XGI, вывело на рынок своих кандидатов на народную любовь – линейку карт Volari, в которой были и самый бюджетные V3 за $49, и внушительные двухчиповые Duo V8 Ultra.

Volari V8 Duo UltraБюджетная V3 была ремаркированной Trident’s Blade XP4, и поддерживала только DirectX 8.1, а карты сегментом выше (включая V5 и V8) строились на базе SiS Xabre, и уже обеспечивали поддержку новейшего API.Но подобная расстановка сил не слишком помогла XGI – среди всей линейки внимания заслуживала только младшая V3, способная потягаться с FX 5200 Ultra и Radeon 9200, тогда как остальные модели безнадежно отстали от конкурентов в своих ценовых сегментах. Например, флагманская Duo V8 Ultra стоила на 20% дороже Radeon 9800 XT, при этом демонстрируя производительность целым классом ниже – как у 9600 XT.Линейка Volari еще возвращалась в поле зрения индустрии в 2005, а в 2010 году XGI снова стала частью SiS.Другой компанией, внезапно решившей вернуться на рынок, стала S3. Будучи поглощенной VIA за $208 миллионов, компания занималась выпуском чипсетов и других интегрированных решений, но желание попытать счастья на прежнем поприще не пропало.Карты серии DeltaChrome были анонсированы уже в январе, однако на полки магазинов добрались только к концу года.

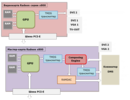

S3 DeltaChrome S8На бумаге новинки выглядели готовыми к противостоянию с двумя титанами – поддержка DirectX 9, шестнадцатикратной анизотропной фильтрации, работа в разрешении 1080p и с портретным форматом дисплея подкрепляли намерение вернуться в игру.К сожалению для S3, карты не получили должного внимания из-за специфики рынка – люди привыкли видеть графический фронт как поле боя двух титанов, и места для третьего игрока в этом противостоянии просто не было. История бренда не закончилась сразу же – на смену DeltaChrome приходили карты GammaChrome, выпущенные в 2005. Но об этом позже.NVidia 6800 – Сегментация для ценителей, «изобретение» SLIСтремительный прогресс шел всё быстрее, и уже в марте 2005 года NVidia представила первую карту с памятью формата GDDR3 – FX 5700, следом за которой вышло поколение GeForce 6, сулящее геймерам покорение новых горизонтов производительности. Серия 6800, нацеленная на high-end сегмент, включала широкую линейку во всех ценовых сегментах, включая базовую версию карты за $299, GT за $399, Ultra за $499 и наиболее заряженную Ultra Extreme, выпуск которых NVidia доверила избранным AIB-партнерам. Рыночная цена эксклюзивной карты ограниченной серии составляла целых $549.

NVidia GeForce 6800 Ultra ExtremeНо, как выяснилось позже, NVidia лишь прощупывала почву. 14 марта 2005 года линейку пополнила 6800 Ultra с 512 Мб видеопамяти на борту за сумасшедшие $899, а следом за ней появилась BFG-версия, стоившая целую тысячу долларов! С этой линейкой лидер рынка впервые проверял на прочность кошельки фанатов, готовых на всё ради передовых графических решений. А для всех остальных, с недоверием глядящих на цены линейки 6800, в сентябре 2005 года NVidia представила более доступную линейку 6600.В техническом плане 6000 серия видеокарт NVidia была впечатляющей – она предлагала поклонникам и полную поддержку DirectX 9.0c, и частичную реализацию шейдеров 3.0, и новый движок декодирования и воспроизведения видео NVidia PureVideo, а также (барабанная дробь) поддержку технологии SLI – аппаратной синхронизации видеокарт, некогда разработанной 3Dfx.Но если 3Dfx видела суть SLI в разделении рабочей нагрузки через разделение рендеринга фреймов (когда каждая видеокарта обрабатывала по половине кадра), то NVidia подошла к работе связок из двух видеокарт немного иначе. Режим split frame rendering (SFR) во многом соответствовал видению 3Dfx, разделяя рендер кадра на верхнюю и нижнюю половину, тогда как alternate frame rendering (AFR) выстраивал кадровый рендеринг в порядке очереди (один кадр рендерила одна видеокарта, следующий за ним – другая). Впрочем, управление технологией во многом зависело от конфигурации драйвера, а множество игр попросту не поддерживало технологию SLI, из-за чего вторая видеокарта не использовалась, и полезность SLI-связок часто становилась объектом споров среди геймеров – к тому же разработчики игр очень неохотно внедряли поддержку новинки в свои проекты.Несмотря на июньский анонс SLI, первые материнские платы с поддержкой технологии на основе чипсета nForce 4 не появлялись в продаже вплоть до ноября. Спорные драйвера и вовсе приводили в порядок до начала 2006 года, только усилив неприятие новой технологии.Но обзорщики не теряли возможности протестировать SLI там, где она была интересна более сего – в бюджетном сегменте. Например, некоторые тесты показывали очевидные преимущества связки из двух 6600 GT (общей стоимостью менее $400) над флагманскими картами в низком разрешении и на низких настройках качества графики. Но как только речь заходила об актуальных разрешениях и пресетах выше «среднего», преимущества SLI переставали быть очевидными. Различные технологические недостатки так и не позволили ни SLI, ни CrossFire продемонстрировать идеальное двукратное скалирование производительности, оставшись уделом энтузиастов и профессионалов. Сегодня в игровом компьютере никто не будет рекомендовать использовать две видеокарты – выгоднее выбрать одну, но мощную.Но партнеры-производители увидели в возвращении технологии немалый маркетинговый потенциал, и компания Gigabyte выпустила не только двухчиповые 6600 и 6600 GT, но и 6800 GT.

NVidia GeForce 6600 GT x2Такие чудеса инженерной мысли требовали не только новейшего чипсета nForce 4, но и моделей материнских плат исключительно производства Gigabyte.Там же, где одночиповые карты всё еще правили балом, на вершине бенчмарков и тестов сражались 6800 Ultra и Radeon X800 XT/XT PE от ATi. Обе карты шли ноздря в ноздрю в тестах, и даже страдали от тех же проблем – так флагман ATi вышел в мае 2005 года и присутствовал на прилавках лишь ограниченными тиражами до конца жизненного цикла, а 6800 Ultra и вовсе вышла в продажу только в августе, оставшись больше коллекционной картой – даже партнерских версий флагмана NVidia было всего несколько.Зато этажом ниже NVidia вышла в лидеры – 6800 GT с комфортом обходила X800 Pro в ценовом сегменте в $399, тогда как 6600 GT доминировала в категории видеокарт до $200.Иронично, но серьезная конкуренция со стороны NVidia практически не сказалась на рекордных прибылях ATi в $204.8 миллиона при общем обороте практически в $2 млрд.6600 GT, несмотря на свой культовый статус и бешеную популярность, пала жертвой явной технологической спешки. Дело в том, что карта использовала новейшую шину PCI-e, которая в 2005 году была доступна только зажиточным владельцам новой платформы Intel Pentium 4. При этом материнские платы AMD, которая была технологическим лидером с передовыми двухъядерными процессорами AMD 64, всё еще использовали AGP-шину, и решение NVidia оставить за бортом массу фанатов новых видеокарт осталось непонятным. NVidia 7000 vs Radeon X1000 – Ожесточенная схватка за лидерствоОпасаясь потерпеть поражение от нового поколения ATi, NVidia начала выпускать модели 7000 серии еще выхода в продажу полной линейки предыдущего поколения. Новая 7800 GTX появилась на прилавках за 5 месяцев до того, как была представлена урезанная 6800 с префиксом GS.

NVidia GeForce 7800 GTXСпешка с выпуском новинок была так велика, что в процессе NVidia успела сменить техпроцесс – если первые карты изготавливались на 110 нм техпроцессе от TSMC (7800, чип G70), то последующие использовали более совершенный 90 нм техпроцесс (7900, чип G71).И хотя обозначение чипов сменилось с привычного NV на G, новая архитектура во многом напоминала чип NV40, лежащую в основе 6000 серии. При минимальной разнице в размерах новый чип имел на 8 миллионов транзисторов больше, число пиксельных конвейеров выросло в 1.5 раза, а вертексных стало больше на треть. NVidia заменила всю линейку моделями на базе G70 уже через девять месяцев после премьеры 6000 серии, а карты классов GS и GTX (на 512 Мб) и вовсе сменили предшественников всего через 3 и 4 месяца соответственно. Так Дженсен Хуанг еще никогда не торопился.

Интересные технологические решения были реализованы даже в бюджетных моделях. Например, в 7200 GS была реализована технология TurboCache, позволявшая видеокарте использовать системную память компьютера после исчерпания бортового буфера – впервые NVidia испытала её в GeForce 6200 TC, но технология показала себя более чем жизнеспособной – она активно используется до сих пор.Что же до флагманских карт, 7800 GTX с 256 Мб на борту появилась в продаже 22 июня по не самой демократичной цене в $599.

NVidia GeForce 7800 GTXАжиотаж вокруг новинки был настолько велик, что цены зачастую оказывались куда выше рекомендованных. ATi ответила выпуском X1800XT, отняв титул самой производительной карты, но уже пять дней спустя NVidia выпустила 7800 GTX с 512 Мб памяти, вернув себе звание «самой-самой».

ATi Radeon x1800 XTДва месяца спустя ATi продолжила с X1800XTX, которая навязала конкуренцию флагману NVidia, и стартовала новый этап гонки за производительностью – обе карты стоили в районе $650, а одно из партнерских решений канадского флагмана даже предлагало геймерам разъем dual-link DVI, через который можно было играть в разрешении 2560х1600 (!) при высоких настройках графики. ATi CrossFire и новинки X1000 – Исторические рекорды и новые горизонтыВ мае 2005 года ATI представила собственную технологию работы с несколькими видеокартами – CrossFire. Премьера новинки состоялась в сентябре одновременно с выпуском специального чипсета Xpress 200 Crossfire Edition и материнской платы X850 XT Crossfire Master. Первоначально из-за одноканального видеоконтроллера разрешение экрана с использованием парных карт ограничивалось 1600х1200 при 60 Гц, но уже в скором времени появление двухканального DVI решило проблему и довело его до 2560х1600.В отличие от NVidia, объединяющей два одинаковых адаптера через мостик, ATI использовала мастер-карту с TDMS-ресивером, подключая второй адаптер через внешний Y-кабель и используя чип Xilinx.

CrossFire предлагал идентичные SLI технологии работы рендеринга, но при этом имел и собственную разработку SuperTiling. Технология позволяла заметно увеличить производительность в некоторых играх и приложениях, однако не работала с OpenGL, и не поддерживала ускоренной обработки геометрии. О проблемах с драйверами и играми, как и в случае с SLI, можно даже не упоминать.Несмотря на план ATi выпустить первые видеокарты с поддержкой шейдеров 3.0 еще в июле (на новом чипе RV520), обнаруженный в архитектуре критический баг затянул подготовку новинки на целых 4 месяца.Начальная линейка включала модели X1800 XL/XT на базе ядра RV520, бюджетную линейку карт X1300 на урезанном R515 (имевшим 25% конвейеров флагмана), а также X1600 Pro/XT на основе RV530, ставшую золотой серединой по общей производительности.

ATi Radeon x1800 XT 512 МбИз-за задержки с выпуском X1800 её уже через три с небольшим месяца заменил новый флагман X1900 на базе чипа RV580. Ситуация во многом напомнила спешку NVidia с переходом на 7000 линейку, разве что ATi не торопилась. Прогрессивный 80-нм техпроцесс TSMC позволил запустить полное обновление линейки, куда вошел чип RV570 (X1650 GT/XT и X1950 GT/Pro) и уменьшенный RV530, ставший основой бюджетных видеокарт X1650 Pro и X1300 XT.Плотный график релизов и большие успехи на фронте графических карт позволили ATi установить абсолютный рекорд выручки в $2.2 млрд – больше, чем когда-либо в своей истории. Необъемлемой частью этого достижения были поставки графических чипов Xenos для консоли XBox 360 и неизменно высокий спрос на мощные видеокарты, который подогревала NVidia. С другой стороны, рекордным оборотам сопутствовали скромные цифры чистой прибыли – менее $17 млн.S3 Chrome – Образчики старой школыЗатяжное противостояние двух графических гигантов на рынке видеокарт привело к тому, что многие хотели увидеть новое лицо – просто для разнообразия, из чистого любопытства. Именно поэтому возвращение на рынок компании S3 было встречено с энтузиазмом.

S3 Chrome S27CВидеокарты серии Chrome вышли в ноябре 2005 года, и представляли собой бюджетные модели S25 и S27, нацеленные на ценовой сегмент от $95 до $125. Обладая высокими частотами, видеокарты неплохо конкурировали с 6600/6600GT и X1300Pro/X1600Pro, но были абсолютно безликими, не имея никаких интересных преимуществ помимо сниженного энергопотребления. Пока S3 решала, что же придумать для поддержания линейки, её единственное преимущество кануло в лету, когда ATi и NVidia выпустили новые бюджетные хиты, заранее похоронив будущие Chrome 400 и Chrome 500.К сожалению для S3, высокие затраты на производство ставили крест на прибыльности компании. Пробыв нишевым поставщиков для HTPC-рынка еще какое-то время, компания была приобретена HTC за $300 млн в июле 2012 года. Такая покупка во многом была стратегическим решением – обе компании выдвигали претензии к Apple, и рассчитывали достичь успеха на судебном поприще, консолидировав иски. А ATi и NVidia продолжали противостояние в 2006 году...ATi vs NVidia – Последняя битваАктивные приобретения сторонних компаний никогда не были чужды ATi, и расширение портфолио продолжалось. Сначала была приобретена Microsynergy, инженерно-дизайнерская фирма из Шанхая с представительством в Калифорнии, прежде принадлежавшая XGI. В мае 2006 года ATi выкупила пафосных BitBoys за $44 млн.А NVidia впервые в своей истории вывела в продажу двухчиповую видеокарту – ей стала 7800 GT2, на борту которой располагались два чипа 7900 GTX с пониженными частотами.

NVidia GeForce 7800 GT DualПафосный релиз стал курьезным по вине ASUStek, решившей первой порадовать поклонников зеленых карт с фирменной Extreme N7800GT Dual. Карта вышла ограниченным тиражом в 2000 экземпляров, стоила $900, и вышла на рынок раньше монстра самой NVidia. Правда, был один нюанс – в основе партнерского монстра лежало два чипа 7800 GT.Несмотря на спорную природу и все минусы двухчиповых карт новинки от ASUStek произвели фурор, ставший началом появления целого ряда экзотических экспериментов бренда как в одном, так и в другом лагере.Объемный рынок железного мейнстрима продолжал оставаться в руках NVidia – её 7800 GT и GS завоевывали всё новых и новых поклонников из массовой публики, а хардкорные энтузиасты выбирали тяжеловесов от ATi – первые места по производительности оставались за X1950XTX и другими картами, выступающими в CrossFire-связках. За фанатов красивой графики сегментом ниже борьба шла не на жизнь, а на смерть – X1900 XT и GeForce 7900 GT во многом были равны, и делили между собой целый сегмент рынка. А потом случилось невероятное.После 21 года на рынке в качестве независимой компании, ATi приняла предложение о покупке со стороны AMD. Это произошло 25 октября 2006 года – сумма сделки составила внушительные $5.4 млрд, среди которых фигурировали $1.7 млрд от AMD, $2.5 млрд от кредитных организаций и инвесторов, 57 миллионов акций AMD и 12 миллионов опционов с ограниченным оборотом на сумму $1.2 млрд. Драматизма ситуации придавал и тот факт, что более 60% прибыли на момент продажи компании ATi получала от производства чипсетов и встроенной графики для материнских плат Intel.

У Intel не оставалось выбора, и все контракты, связанные с выпуском чипсетов и встроенных решений, были переданы NVidia – доля рынка ATi рухнула.

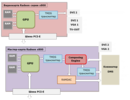

Хотя AMD придерживалась вполне понятной логики – компания отчаянно нуждалась в собственном графическом подразделении для работы над экосистемой Fusion (так назывался концепт APU – процессора со встроенным графическим ядром) а также реализацией инициативы Torrenza (принципов эффективного менеджмента соединений и управления ресурсами устройств по шине PCI-e в составе систем на базе Opteron). Учитывая специфику, самым логичным (и доступным) вариантом было приобретение одной из компаний сферы. Легенда гласит, что когда Дэвид Ортон из AMD позвонил Дженсену Хуангу и назвал сумму для покупки его компании, тот истерически хохотал до тех пор, пока Ортон не повесил трубку. В тот самый момент в AMD уже знали, какую из компаний решено приобрести.СплетниЛегенды легендами, но Хуанг полностью подготовил и утвердил все бумаги о слиянии с AMD, суммы полностью его устраивали, тем более основным пунктом в контракте было условие, что именно он возглавит AMD после слияния. Отклонили слияние именно в AMD, т.к не поняли такой наглости - они полностью оплачивают слияние и при этом еще и Хуанг становится главой... На абсолютно тех же условиях AMD сразу обратились к ATI и там согласились - добавив в контракт только пару пунктов - сохранение сотрудников и штаб-квартиры в Канаде. А Хуанг сразу побежал к VIA и предложил солидную сумму, но, помня как Хуанг распотрошил 3Dfx, они отказались, сославшись на недостаточную сумму... Самое интересное, что именно в тот год доля поставок чипов графики от ATi перевалила за 50% и они фактически были лидерами рынка графических решений, хотя суммарный выторг и отставал от NVidia.С драматичными изменениями на рынке настали и фундаментальные перемены для всей компьютерной графики – начиналась эпоха унифицированных архитектур.2006-2011. Начало эпохи AMD vs NVidia. Унификация архитектур. Новые легенды. Старые раны8800 GTX/Ultra – Аннигилятор за $500 млнДо появления DirectX 10 у производителей видеокарт не было никакого смысла в увеличении размеров кристалла несмотря на некоторые предпосылки. Одной из весомых причин производить огромные чипы мог стать функциональный рост вертексных шейдеров. С развитием вертексной графики могла появиться необходимость повышения производительности пиксельных шейдеров, и поддержка 32-битных операций с плавающей запятой. Усложнения архитектур видеокарт удалось избежать благодаря появлению DirectX 10, объединившему функциональные роли двух разных классов шейдерных блоков. Появление унифицированных шейдеров, о которых мы возвестили чуть выше, позволило значительно сократить площадь кристалла и повернуть в иное русло развитие всей индустрии видеокарт. И первым чипом, воплотившим в жизнь новую концепцию, стал легендарный G80.NVidia дорого заплатила за право быть первой – 4 года напряженной работы с $475 миллионов бюджета R&D привели к долгожданному анонсу одной из самых знаменитых видеокарт в истории – GeForce 8800 GTX.

NVidia GeForce 8800 GTXБыли у карты как урезанная версия 8800 GTS, так и «заряженная» 8800 Ultra – настоящий шедевр инженерной мысли, воплотивший в себе пик возможностей G80. Флагманы вышли в продажу 8 ноября 2006 года, а две версии GTS (на 320 и 640 Мб) последовали в феврале и конце ноября будущего года.Ключом к успеху новой линейки стало внедрение алгоритма сглаживания CMAA (Coverage Sampling Anti-Aliasing или Выборка сглаживания с перекрытием), сочетающего высокую производительность с эффективным АА-алгоритмом. AMD, наблюдая за ситуацией со стороны, заключила ряд выгодных ОЕМ-контрактов, повысивших общую долю рынка красных на 3%.Самым серьезным нововведением в этом поколении стала технология CUDA, разработанная NVidia для новой архитектуры. Она стала доступна разработчикам и бизнес-партнерам в формате SDK-билда, включавшего фирменный физический движок NVidia PhysX с сопутствующими программами, профессиональные инструменты для виртуализации, а также Optix – движок компании для трассировки лучей, которая уже тогда начала приобретать популярность в профессиональной среде. Именно CUDA в качестве архитектурного решения легла в основу всех последующих поколений видеокарт NVidia – и продолжает использоваться по сей день.Что же до профессионалов, то их ожидал восторг в виде выпуска вычислительных сопроцессоров Tesla, дополнивших и без того впечатляющие линейки в виде геймерской серии и Quadro FX 4600/5600 на том же чипе G80. Все с нетерпением ждали ответа со стороны AMD - и первый блин у компании вышел комом.Radeon HD2900XT – Худшая из посредственныхПосле приобретения ATi в недрах AMD закипела работа над чипом R600, который не только обрастал слухами и подогревал интерес, но и успел пройти настоящий производственный ад. Новая видеокарта, выпуск которой был отложен три раза, увидела свет в мае под горячие превозношения прессы – но даже они оказались бессильны перед недостатками HD2900XT.

AMD Radeon HD 2900 XTНовинка с агреcсивно-яркой красной турбиной была шумной, горячей и обладала аппетитами high-end видеокарты, хотя производительность оставляла желать лучшего. Это было, скорее, решение средней руки, затяжные проблемы которого заставили выкупленную ATi серьезно пересмотреть подход к будущим разработкам. Плодами подобных перемен стал выдающийся чип RV770 (семейство Evergreen), но и у R600 хватало технических побед, несмотря на общую посредственность.Чип в 420 мм2 был самым крупным в истории ATi/AMD, и лег в основу первой видеокарты с поддержкой DirectX 10, огромной шиной памяти в 512-бит, отдельным чипом тесселятора (который по факту так и остался неиспользованным из-за отсутствия его поддержки в DirectX), возможностью обеспечивать аудиосигнал через HDMI, а также архитектуры VLIW, которая заложила основу для всех будущих карт AMD вплоть до появления GCN. Был и один неприятный рекорд, ведь у бренда Radeon впервые за долгое время не было видеокарты, способной потягаться с NVidia в высшем эшелоне. Но продлиться такое слишком долго, само собой, не могло.Radeon HD 3870 х2 – Возвращение в лидерыAMD начала с обновления чипа R600 до RV670, портировав разработанную архитектуру с 80 нм TSMC на новейшие 55 нм, заменив громоздкую бидирективную кольцевую шину памяти на более традиционную 256-битную.

Это позволило сократить размер кристалла практически вдвое, сохранив схожее число транзисторов (666 миллионов против 700 у оригинального R600), а добавление поддержки DirectX 10.1 вкупе с шиной PCI Express 2.0 позволили неудачной серии конкурировать с 8800 GT и другими королями мейнстрима того поколения.В январе 2008 года AMD анонсировала выпуск первой двухчиповой карты на основе доработанной архитектуры – ей стала HD3850 х2, появившаяся на полках магазинов в апреле. Уже в июне презентовали и её старшую сестру HD3870 х2.

AMD Radeon HD 3870 x2К выходу новинок AMD разработала стабильный набор драйверов и обеспечила картам отличную поддержку – критики пели дифирамбы, и восторженная публика сметала карты с полок. HD3870 х2 мгновенно стала носить титул «самой производительной видеокарты», а её младшая версия была лишь немногим медленнее. CrossFire больше не требовал специальных кабелей и других «костылей», - AMD переработала технологию, которая теперь работала на любых материнских платах с поддержкой двух разъемов PCI-e.Наряду с прогрессивным флагманом были выпущены и бюджетные решения на чипах RV620 и RV635 – среди них, например, была последняя видеокарта, выпущенная под классическим брендом All-In-Wonder, HD3650.8800 GT – Недорогой успехКолоссальный успех G80 дал NVidia мощный плацдарм для дальнейшего развития архитектуры, и доработанный чип G92 стал основой 8800 GT, вышедшей 29 октября 2007 года.

NVidia GeForce 8800 GTНевероятно вкусная цена (за модели с 512 Мб памяти просили не более $250) и производительность, опередившая HD 2900 XT и HD 3870, а также опасно близкая к легендарной 8800 GTX, мгновенно сделали новинку желанной во всем мире. Запасы видеокарт постоянно истощались, и приобрести заветного чемпиона было сложно уже в первые недели продаж. Нетрудно догадаться, что именно благодаря успешным релизам NVidia увеличила свою долю рынка до 71% к концу года.11 декабря по пятам 8800 GT вышла 512 Мб версия 8800 GTS на доработанном чипе. Несмотря на ощутимо более высокую цену, старший брат GT мог похвастаться серьезным разгонным потенциалом – отборные чипы в руках энтузиастов нередко догоняли 8800 GTX, а самые лучшие образцы показывали уровень производительности 8800 Ultra.Но у 8 серии GeForce была ахиллесова пята – припой с высоким содержанием свинца, который использовался в BGA-чипах G86, G84, G73, G72/72M, а также C51 и MCP67. Низкий температурный порог плавления припоя, проблемы с охлаждением у референсных моделей и большое число циклов нагрева и охлаждения приводили к тому, что многие видеокарты начинали артефачить и вскоре умирали. Легендарные «отвалы» впервые появились как явление именно тогда, и много лет оставались проблемой горячих и прожорливых карт обоих производителей.К середине 2008 года NVidia полностью перешла на использование припоя Hitachi (где вместо свинца использовался цинк), и переработала дизайн системы охлаждения для своих карт 8 серии – кожух сменил очертания и получил новую конструкцию для лучшего отвода тепла, а вентилятор прибавил в числе лопастей для увеличения потока воздуха. Меньше всего волновались владельцы партнерских карт на G92 – два мощных вентилятора и продуманное охлаждение спасало чипы от трагичного финала (что, как минимум, продлевало жизнь видеокартам на несколько лет).Различные расходы, связанные с выходом из строя видеокарт, а также с переходом на новый припой, стоили NVidia почти $476 млн. Особенно пострадали пользователи ноутбуков, в которых были установлены мобильные версии видеокарт на G92 – видеоядра массово выходили из строя, но производители, прекрасно зная об изъянах продукции, не спешили что-либо предпринимать. NVidia получила серьезный удар по репутации – впрочем, как показала история, Дженсен Хуанг всегда любил заигрывать с судьбой.

GeForce 9000 – Ленивое воскресенье после рабочей субботыНасколько революционным была 8 серия NVidia, настолько же пресной и ленивой оказалась её преемница. Первой моделью в линейке стала 9600 GT, основанная на «новом» G94 – который, по сути, был лишь уменьшенным G92, изготовленным по всё той же 65-нм технологии TSMC.

NVidia GeForce 9600 GT ESПадение цен и агрессивная конкуренция между успешными HD3850/HD3870 и различных моделей 8800 GT поставили 9 серию в неловкое положение, наклеив скучный ярлык «ребрендинг» на все вышедшие позже карты линейки.И это было не преувеличением – первые 9800 GT были простой ремаркировкой 8800 GT, а бывшие 8800 GTS превратились во «флагманские» 9800 GTX. Благодаря переходу на прогрессивные 55 нм TSMC NVidia сократила площадь кристалла на 20% и повысила рабочие частоты видеочипа, выкатив на рынок 9800 GTX+, а также её ОЕМ-варианты GTS 150 и GTS 250, вышедшие через 18 месяцев после триумфального дебюта 8 серии видеокарт.Новая линейка GT200 на свежей архитектуре откровенно запаздывала, а лидерство AMD с HD3870 х2 никак не устраивало Хуанга, поэтому в очередной раз зеленый бренд подготовил двухчиповую флагманскую карту, использовав два ядра 9800 GT, и назвав новинку 9800 GX. Две видеокарты в одной сразу же вырвались в лидеры, и вернули утраченное преимущество NVidia, однако далеко не все были в восторге от цены – флагман стоил больше, чем 3 топовые 9800 GT вместе взятые.GT200 VS HD4000 – Новая битва титановВ июне 2008 года NVidia представила долгожданное новое поколение, с которым ввела в обиход долгоиграющий бренд GTX и сформировала порядок анонсов, которого потом придерживалась более 10 лет.Публике были представлены два типа продуктов – флагманская GTX 280 и массовая GTX 260, символизирующие самые приоритетные сегменты рынка, помимо которых NVidia проявила интерес к профессиональному рынку и развитию направления GPGPU.

NVidia GeForce GTX 260Благодаря развитию новых вычислительных алгоритмов и внедрению в архитектуру отдельных конвейеров для численных операций с двойной точностью (FP64) зеленые впервые в истории пересмотрели отношение к профессиональному рынку, и вывели его в приоритет будущих продаж. Геймерам же больше всего запомнилась устрашающая цена GTX 280 в $649 и набор 3D Vision – комплект трехмерных очков с инфракрасным портом для работы одноименной технологии.Но непомерные амбиции NVidia быстро сошли на нет – сразу с выходом HD 4870 и 4850 GTX 280 резко подешевела до $400, а GTX 260 – до $300. И причины у такого смещения цен были вполне понятные.С серией HD4000 связана не самая приятная история – за неделю до официального старта продаж ряд ретейлеров (из-за путаницы или безалаберности) начал продавать видеокарты заранее, нарушив NDA и испортив сюрприз для всех ожидающих. По удачному стечению обстоятельств первой на прилавки попала бюджетнная HD 4730, ориентированная на нетребовательных игроков и офисный сектор, и только через 2 недели к ней присоединились HD 4850 и HD 4870, основанные на новейшем чипе RV770.

AMD Radeon HD 4870 512 МбПо доброй традиции AMD не стеснялась демонстрировать технологические преимущества новинок. HD4000 были первыми картами на рынке, оснащенными памятью GDDR5, умели передавать звук формата 7.1 через HDMI (используя кодек LPCM), показывали прекрасную производительность и практически идеальное скалирование в режиме CrossFire, при всем этом сохранив вкусные цены на радость массовому потребителю. Нетрудно догадаться, что профессиональные обзоры на дуэт карт этой серии HD были более чем хвалебными – критике в очередной раз подверглись лишь референсные модели с неэффективной и шумной турбиной, из-за которой подсистема питания часто перегревалась, и карты выходили из строя раньше времени. Чаще всего подобные проблемы наблюдались в жестких стресс-тестах вроде FurMark, но и рядовые любители сэкономить двадцатку были недовольны.В августе 2008 года триумфальное шествие GTX 280 завершилось с выходом нового двухчипового короля чартов – HD 4870 x2, нового решения #1 во всех бенчмарках, но не только в производительности, но и в звании «самого горячего и шумного флагмана».

AMD Radeon HD 4870 x2NVidia провела много времени на 55 нм техпроцессе, выпустив обновленные ревизии своих чипов на степпинге B3 в январе 2009 года. Тогда же появилась и двухчиповая GTX 295, и её младшая одночиповая сестра GTX 275, которая практически сразу же столкнулась с серьезной конкуренцией – в апреле 2009 года AMD выпустила доработанный чип RV790XT, который лег в основу флагманской HD 4890, а параллельно с ней в продажу вышла первая 40-нм видеокарта HD 4770.По иронии судьбы, сырой и проблемный 40-нм техпроцесс TSMC, грозивший серьезными убытками производителям видеокарт, у AMD как раз пришелся на бюджетную, почти незаметную HD 4770. Инженеры компании получили бесценный опыт и смогли устранить множество дефектов, связанных с особенностями техпроцесса. Например, из-за дефектов производства слои субстрата часто не обеспечивали идеальный контакт с чипом, а утечки токов варьировались от малозначительных до катастрофических, пагубно влияя на общее качество видеокарт. NVidia тоже пришлось столкнуться с этими проблемами позже, но пострадала от этого не пара отдельных карт, а вся серия Fermi, - ей суждено было стать самым громким провалом в истории компании.Первыми продуктами NVidia на 40 нм стали компактные GT205, 210 и GT 220 – ОЕМ-решения, по иронии судьбы первыми же получившие полную поддержку DirectX 10, вывода семиканального звука по HDMI, кодека LPCM а также работу с форматами Dolby True HD/DTS-HD/-HD-MA. Три компактные видеокарты выпускались с акцентом на работу с домашними кинотеатрами, и они же были забытой 300 серией, тихого ребрендинга NVidia в феврале 2010 года.HD5850 и 5870 – Вечно зеленые из лагеря красныхЕсли в жизни бывших ATi и был момент безусловного успеха, то им стало поколение HD5000. Семейство видеокарт под кодовым названием Evergreen использовало уже обкатанный инженерами 40-нм техпроцесс, не страдавший от производственных дефектов и недостатков благодаря малозаметной, но такой полезной HD4770. AMD была готова покорить вершину в очередной раз, и выпустила дебютантами линейки флагманскую HD5870 и более доступную HD5850.

AMD Radeon HD 5870Момент релиза был выбран невероятно удачным – выход Windows 7 и появление нового API DirectX 11 способствовали росту спроса на новые технологии, и карты HD5000 были готовы порадовать поклонников передовой графики и технических решений. Поразила публику и технология Eyefinity – используя широкие возможности DisplayPort AMD обеспечила поддержку до шести видеосигналов одновременно для каждой видеокарты.

За их обработку мог отвечать или внешний цифро-аналоговый преобразователь (в кабеле или мониторе), или же трансмиттеры на самой видеокарте при использовании соединения DP.Предыдущие видеокарты использовали для подключения нескольких мониторов комбинации разъемов VGA, DVI или HDMI, каждый из которых обрабатывал видеосигнал на своей частоте, не говоря уже об усложнении конструкции видеокарты. С появлением DisplayPort необходимость синхронизировать разные частоты видеосигнала отпала, и AMD реализовала одновременный вывод шести источников видеосигнала, доверив достройку изображения программной части и драйверам. Программные меры включали не только компенсацию переходов от одной части изображения к другой, но и масштабирование общего изображения на экране с учетом числа подключенных мониторов.Несмотря на ряд сложностей с фильтрацией текстур, HD 5850 и HD 5870 получили признание в качестве лучших видеокарт 2010 года – доступность, завидная производительность и экономичность обеспечили AMD лидирующие позиции в чартах, а с появлением двухчиповых HD 5950 и HD 5970 игроки получили мощнейшие решения из существующих на рынке.Лишь в апреле 2010 года NVidia была готова ответить собственными новинками, но ответ оказался поколением, которому суждено было стать самым худшим за всё время существования компании. GTX 480 и 470 на базе GF104 на полгода опоздали к аншлагу новых любимцев публики, и запомнились в исключительно плохом качестве. Причиной было стечение обстоятельств, и отчаянная спешка за AMD – не имея опыта работы с 40 нм техпроцессом, NVidia прошлась по всем возможным граблям со своей новой архитектурой.

NVidia GeForce GTX 480Чип Fermi GF100 был невероятно огромным – 529 мм2 и требовал серьезной системы охлаждения, а общие архитектурные недостатки лишили фанатов зеленых шансов увидеть равносильное противостояние с красными.Профессиональные адаптеры серий Quadro и Tesla пострадали от технических проблем куда меньше – во многом этому способствовала развитая экосистема и крупные контракты, держатели которых были заложниками отсутствия альтернатив. Что же касается технических особенностей, именно у Fermi впервые появился суперсэмплинг-бутерброд TrSSAA, работающий в паре с локальным сглаживанием CSAA.Но насколько провальным был запуск флагманской GTX 480, настолько же успешной стала мейнстримовая GTX 460 на базе чипа GF104.

NVidia GeForce GTX 460Версия на 768 Мб вышла на рынок по рекомендованной цене всего в $199, тогда как за 1 Гб NVidia просила лишь $229 – от гордости и маркетинга в стиле «карты премиум-класса» не осталось и следа. Низкие частоты референсных карт, обусловленные стремлением NVidia к снижению энергопотребления, не особенно волновали партнеров, представивших широкий выбор отличных моделей с качественным охлаждением и прекрасным разгонным потенциалом. Тем не менее, преодолеть скепсис публики по отношению к Fermi было непросто – большинство не сомневалось, что половина чипа GF100, с таким трудом оптимизированная NVidia ради успеха в массовом сегменте рынка, скоро станет историей, о которой будут вспоминать разве что такие, как мы...Тем более AMD уже вовсю готовила следующее поколение, и шансы показать зеленым, кто тут царь и бог бенчмарков, были велики, как никогда. А потом случилось невероятное – свет увидел рефреш, окупивший все грехи прошлого. NVidia собрала волю в кулак, и представила доработанные чипы GF110 и GF100, и основанные на них GTX 570 и GTX 580.

NVidia GeForce GTX 580Прежние проблемы как рукой сняло – но люди, раззадоренные гонкой, предвкушали мощный ответ AMD.HD 6000 – Снова всё наоборотНовое поколение AMD под кодовым названием Северные Острова (Northern Islands) появилось в продаже октябрьской порой 2010 года. Будучи не революцией, а скорее эволюцией чипа Evergreen, Barts (первый GPU в линейке) проектировался с акцентом на сокращение производственных затрат и увеличение прибыли. Производительность бюджетных новинок оказалась не так далека от HD 5830 и HD 5850, при этом сама архитектура была серьезно оптимизирована. AMD переработала стриминговые процессоры, отделив от них прежде привязанное число шейдерных конвейеров, уменьшила в размерах контроллер памяти (немного снизив рабочие частоты), и лишила новый GPU возможности проводить двойные точные операции, четко обозначив рамки новой видеокарты. Помимо этого, Barts значительно опережал предшественника в работе с тесселяцией, что было важно на фоне растущей популярности технологии с подачи NVidia.Не похваставшись значительным ростом производительности, AMD уделили большое внимание технической стороне – DisplayPort был обновлен до версии 1.2 (она позволяла подключать несколько мониторов в Eyefinity через один видеовыход с частотой обновления 120 Гц и высокими разрешениями экрана), HDMI – до 1.4А (с поддержкой 3D-видео в 1080p и 4К-разрешения), а декодер видео получил поддержку DivX.Для новой линейки было выпущено новое поколение драйверов с поддержкой морфологического сглаживание (MLAA), а также фильтра размытия для пост-процессинга (который, впрочем, во многом оказался не востребован).

AMD Radeon HD 6970С выходом флагманских карт HD 6950 и HD 6970 в пакет драйвера Catalyst добавили режим сглаживания EQAA (обеспечивающий улучшенное качество картинки при минимальном влиянии на производительность), номинальную поддержку HD3D и возможность динамического управления питанием с помощью PowerTune. Именно эта технология, открывшая возможности увеличения максимального порога питания, стала ключевой для настроек многих будущих поколений AMD, и активно используется до сих пор. С точки зрения архитектуры AMD с серией HD6000 впервые сменила VLIW5, лежавшую в основе всех графических процессоров марки еще с R300, на VLIW4, где в архитектуре шейдерных конвейеров недосчитались одного исполнительного блока. Большие перемены ждали красных дальше – но о них мы расскажем уже в следующей главе материала.GeForce 500 – Работа над ошибкамиЧипы Cayman, как можно было догадаться, без особого труда опережали Fermi по всем статьям – но выход доработанной линейки GTX 500 спутал красным все карты, вновь переместив AMD в категорию догоняющих. Новые ревизии чипов GF100 решили все проблемы своих предшественников – прочувствовав на себе все недостатки сырого техпроцесса, NVidia быстро реабилитировалась в глазах геймеров. Во многом этому помогла поистине народная GTX 560 Ti – карта, в основе которой лежал доработанный чип GF110 (в виде GF114).

NVidia GeForce GTX 560 TiЕй оказалось по силам повторить сумасшедший успех GTX 460, а богатейшая линейка партнерских вариантов была настолько широка, что каждый фанат зеленых без труда нашел в ней полюбившуюся модель. Секретом успеха новинки была низкая цена – и AMD сразу же пошла на контрмеры, резко понизив цены HD 6950 и HD 6870. В глазах обозревателей былая привлекательность 560 Ti вдруг стала неочевидна, и такие карты, как 1 Гб версия HD 6950, рассматривались как «рекомендуемые к приобретению».Стремясь закрепить своё звание лидера рынка, NVidia в очередной раз приготовила двухчиповую карту, созданную с мыслью о бескомпромиссной победе. GTX 590 с двумя кристаллами GF110 на борту поступила в продажу 26 марта 2011 года, и сразу столкнулась с неожиданными неприятностями.

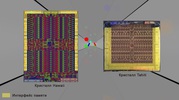

NVidia GeForce GTX 590Релизный драйвер некорректно управлял напряжениями GTX 590, что вкупе с задранными вольтажами BIOS выводило рабочие напряжения за рамки допустимых, эффектно выжигая мосфеты системы питания. NVidia пришлось в срочном порядке выпускать новую версию драйвера и свежий BIOS с новыми ограничениями, но в день релиза гнев профильной прессы был просто невероятным. Сказалось и то, что выпущенная AMD за две недели до этого двухголовая HD6990 показывала схожие результаты в бенчмарках. Народ принялся спорить, какая же из карт круче, дискуссии переходили в срачи, но одно было ясно – революции не произошло. Но до неё оставалось совсем немного...2012-2013. Эпоха раннего GCN. Kepler. Разное настоящее и будущее2011 год ознаменовал начало новой эпохи в истории AMD. После череды уверенных побед на процессорном фронте (триумфов Athlon в 2000 и двухъядерной революции в 2005) и ожесточенной конкуренции в сфере графики (которая не прекращалась ни на год), у компании из Саннивейла начались тяжелые времена. Безумный хайп вокруг выхода новой линейки процессоров AMD FX обернулся катастрофой после их долгожданного дебюта, когда неоднозначные архитектурные решения и ставка на число потоков проиграли решениям Intel по всем фронтам, сильно осложнив финансовое положение компании. По примеру NVidia AMD приняли решение о создании универсальной архитектуры, и плодом работы инженеров стала Graphics Core Next (GCN). К счастью для красных, GCN во многом оправдала возложенные на неё ожидания, и, как в случае с многоядерными процессорами, опередила своё время. Даже 5, а потом и 7 лет спустя продукты на базе GCN продолжают радовать старых и новых фанатов AMD – и это говорит не столько о застоявшемся прогрессе, сколько о том, почему эта архитектура по праву получила статус легенды.HD7000 – Переход к универсальностиА началось всё с HD 7970 – флагманской карты первого поколения GCN на базе чипа Tahiti. Ключевым отличием архитектуры VLIW5 от новой GCN стали акценты и возможности работы на два фронта – ранняя архитектура прекрасно работала с графикой, но при этом показывала удовлетворительный результат в любых вычислительных задачах. В основе VLIW был заложен акцент на максимальный параллелизм типовых задач, выполняемых графическим конвейером, и, руководствуясь принципом «больше – значит лучше», массив простых ALU-блоков максимально эффективно справлялся с конвейером задач, заранее сформированных планировщиком.Но такой подход был неприменим к сложным вычислительным операциям – множество различных задач требовали таких же различных подходов, поэтому прежний сценарий работы оказался неэффективен. Например, хэширование данных или паролей могло работать максимально эффективно на VLIW-архитектуре (из-за типовой схожести с конвейерными графическими инструкциями), но та же декомпрессия текстур уже представляла сложности. Ряд вычислительных операций и вовсе не предусматривал параллельного выполнения алгоритмов, поэтому AMD отчаянно нуждалась в архитектуре по типу «мастер на все руки», которой и суждено было стать GCN.Её появление во многом можно связать и с бурным расцветом профессионального рынка, на который NVidia сделала серьезную ставку в GTX 200, и не сбавляла оборотов уже несколько лет. Линейки Quadro и Tesla пользовались огромным спросом, и внушительная маржинальность рынка и его постоянный рост создавали массу возможностей для конкуренции – у AMD попросту не было продуктов на роль «рабочей лошадки». Выживание компании в условиях глубокого кризиса, вызванного провалами на процессорном фронте, во многом зависело и от прибылей в графике – а жирные чеки там, как известно, почти всегда получала NVidia. GCN была разработана, чтобы спасти AMD.Универсальная архитектура начала для AMD эпоху компромиссов, где пожертвовав потенциальной игровой производительностью чипмейкер получал широкий выбор графических продуктов, способных обеспечить приток крайне необходимых средств в борьбе с NVidia. Карты серии HD7000 (они же Southern Islands) получили поддержку DirectX 11.1 и PCI-e 3.0, обзавелись аппаратным кодеком H.264 и VCE-движком, а также, благодаря переходу на передовой 28-нм техпроцесс уместили на площади в 365 мм2 чипа Tahiti значительно больше транзисторов, нежели во флагмане Cayman.

AMD Radeon HD 7970HD 7970 во многом была ограничена желанием красных вписаться в лимит энергопотребления (установленный в пределах 250 Вт), но вместе с тем для энтузиастов новинка стала настоящей находкой. Флагман AMD на базе GCN, уверенно опередивший GTX 580, мог предложить значительно больше тем, кто не слишком переживал о счетах за электричество. Именно поэтому в скором времени свет увидела «заряженная» версия флагмана – HD 7970 Ghz Edition, а также её младшая сестра HD 7950 Boost.Более доступные HD 7850 и HD 7870 появились уже через 3 месяца после релиза старших карт – в марте 2012 года. Выступая в ценовом сегменте $250 и $350, новинки ознаменовали новый виток развития драйверов с набором современных программных технологий – во многом нововведения коснулись механики работы суперсэмплинга (SSAA) и морфологического сглаживания (MLAA).SSAA, прежде бывший эксклюзивной частью API DirectX 11, «подружили» с DirectX 10, значительно расширив число поддерживаемых игр. По умолчанию в настройках драйвера для суперсэмплинга был включен негативный Level of Detail (LOD), из-за чего повторяющиеся объекты на заднем плане обрабатывались с понижением качества текстур (причем с увеличением дальности прорисовки эффект от такого трюка сильно возрастал, и ощутимо поднимал счетчик фпс). Игрок далеко не всегда замечал подвох, ведь перед глазами всё оставалось красивым и четким, а главное – производительность радовала глаз.Улучшения коснулись и MLAA, фирменного морфологического сглаживания AMD, впервые представленного в 2010 году с HD6000. После того, как многие разработчики игр стали внедрять механизмы сглаживания непосредственно в игры, такая настройка потеряла свою актуальность, но AMD всё еще видела потенциал в развитии фильтра. С выходом линейки Южных Островов в драйверах появилась MLAA 2.0, где не было пенальти производительности, а эффект был похож на мягкий фильтр размытия, не ухудшающий исходного качества картинки. Особенно хорош MLAA был в сочетании с тяжелыми алгоритмами сглаживания (такими, как MSAA), улучшая общее визуальное качество без потерь для игрока – как это было в предыдущей версии фильтра.На момент выхода первой линейки карт на базе GCN у NVidia не было никаких преимуществ помимо привлекательной ценовой политики. HD 7950 и 7970 показали внушительное превосходство над флагманской GTX 580, а 7870 без труда справлялась с GTX 570, оставаясь чуть дороже, но ощутимо быстрее. Единственной неоднозначной картой в линейке была младшая HD 7850 - ей наступала на пятки народная любимица 560 Ti. Тем не менее, даже несмотря на ценовую войну, карты AMD подкупали бОльшим буфером видеопамяти и отличными драйверами, - к тому же новая архитектура как никогда вселяла оптимизм. Ответ NVidia последовал позже – и явно стоил своих ожиданий.GTX 600 – Могучий Kepler и последние двухголовыеНесмотря на шаткий старт и многочисленные технические проблемы, Fermi обеспечила NVidia признание и успех сразу в нескольких сегментах рынка – наиболее весомым из них был, конечно же, профессиональный. Карты серий Quadro и Tesla показали прекрасные вычислительные возможности, и заинтересовали множество крупных компаний. Такая удачная архитектура во многом удовлетворяла NVidia, поэтому Kepler не был создан с чистого листа, а стал своего рода развитием Fermi (прямо как Northern Islands был эволюцией Evergreen).Впервые в истории NVidia подошла к сегментации продуктов более строго – если раньше карта тира х80 имела под собой флагманский чип G80 на котором также строились модели линеек Quadro и Tesla, то в случае GTX 680 премьерная видеокарта линейки Kepler получила GK104 – кристалл целой градацией ниже. Такое решение сразу же натолкнуло поклонников зеленых на мысль о том, что в высшем эшелоне скоро появится нечто невероятное.

NVidia GeForce GTX 680Представленная в марте 2012 года GTX 680 строилась на кристалле площадью всего 294 мм2, и в отличие от флагмана предыдущего поколения архитектурная компоновка располагала втрое большим числом CUDA-ядер (1536 вместо 512 у GTX 580) и вдвое большим - текстурных блоков. Частоты видеокарты были несколько ниже предшественника, но это никак не отразилось на игровой производительности.С Kepler NVidia пришла к унификации частотных значений – отдельные частоты шейдерных блоков ушли в прошлое, и теперь все компоненты работали на частоте ядра. Дополнительно появилась частота GPU Boost – турбо-частота для видеоядра, ставшая третьей цифрой в частотных характеристиках видеокарты. Были решены и проблемы с контроллером памяти – теперь он работал на стабильной частоте в 6 ГГц. Сам релиз поколения Kepler тоже не был похож на типичный полугодовой цикл, в течение которого на рынок постепенно выходила линейка моделей на разный вкус и кошелек. Всего через полтора месяца после презентации GTX 680 NVidia показала свою очередную (и как окажется позже, последнюю) двухчиповую карту GTX 690, а еще неделей позже к дуэту присоединилась более доступная GTX 670.

NVidia GeForce GTX 690В отличие от GTX 590, преимущества которой не позволили выйти вперед в противостоянии с HD 6990, GTX 690 была выпущена не из стремления догнать, а ради упрочнения лидерских позиций. AMD не могла представить своего ответа достаточно быстро, и даже прямого ответа на GTX 580 в компании еще не было (HD 7970 Ghz Edition вышла лишь в конце июня 2012 года), поэтому NVidia воспользовалась форой во времени и преимуществами удачной архитектуры, снабдив свой флагман класса «люкс» ценником в $999.Металлический кожух сменил пластиковый, а массивный радиатор из двух блоков обеспечил равномерное охлаждение – при примерном потреблении в 300 Вт дизайн был критически важной точкой в дальнейшей судьбе карты.

Мощная 10-фазная система питания и 2 8-pin коннектора могли порадовать энтузиастов – из коробки карта потребляла не более 300 Вт, но могла справиться и со значением в 375.Также немаловажной была полноценная поддержка PCI-E 3.0 на системах помимо Sandy Bridge – для этих целей NVidia лицензировала мостик для шины производства PLX, обеспечивающий нормальную работу карты в любых конфигурациях – даже там, где в системе работает одновременно несколько устройств с PCI-E 3.0 и PCI-E 2.0.Единственное ограничение, которое присутствовало на флагмане Kepler – малое число видеовыходов, среди которых 3 были отведены под DVI, и лишь один был отведен для DisplayPort.

Для пользователей, уже оценивших преимущества Eyefinity от AMD, такой набор показался бы скудным. Отметим также, что именно после выхода GTX 590 NVidia представила свою знаменитую утилиту GeForce Experience – продукт подбора оптимальных игровых настроек для любой из актуальных видеокарт бренда. Забавно, но компания, которая в 2012 году была на пике программных инноваций, всего несколькими годами позже перешла к полному консерватизму, уступив пальму первенства AMD.Что же касается бюджетного и high-middle сегмента, то здесь впервые было представлено целых три видеокарты – GTX 670, GTX 660, GTX 660 Ti. Первая выступала на уровне с HD 7950, находясь в той же ценовой категории, остальные две поделили рынок, создав серьезную сегментацию там, где прежде её не было. Значительно позже набор пополнился бюджетными GTX 650 и 650 Ti, завершив основную линейку видеокарт. Тем не менее, несмотря на технологические преимущества и развитие Fermi как архитектуры, невероятных преимуществ над AMD у линейки GTX 600 так и не появилось. А флагманская GTX 690 повторила судьбу предшественницы, когда вышла HD 7990, предложившая схожий уровень производительности. Особняком стояла лишь GTX Titan, выпущенная в первую очередь для профессионального рынка, но при желании располагающая ресурсами, чтобы потягаться за верхние строчки бенчмарков с GTX 690 и HD 7970 GE. Тем не менее, для AMD поколение Kepler не стало серьезной проблемой, а GCN, несмотря на ряд недостатков, достойно конкурировала с новинками NVidia.GTX 700 – И снова KeplerПосле выхода первого поколения GCN безусловное лидерство NVidia практически не присутствовало в различных сегментах рынка – модели класса HD 7850 и 7870, а также HD 7950 и 7970 прекрасно конкурировали с мощными GTX 670 и 680, и даже выход двухчиповой GTX 690 обеспечил победу NVidia всего на несколько месяцев – ровно до тех пор, пока AMD не представила собственного монстра HD 7990. Тем не менее, из-за сложного финансового периода фанаты красных едва ли могли ожидать радикальных изменений в GCN, что с учетом шаткого паритета в 2012 году давало NVidia все шансы вырваться далеко вперед.На этот раз NVidia не спешила с представлением очередной линейки, и во многом пауза была связана с циклом производства кремниевых пластин TSMC. Если во времена GTX 400 большинство чипов сходили с конвейера неполноценными (в бракованных кристаллах отключалась часть конвейеров, чтобы обеспечить высокий процент «живых» ядер), то к премьере Kepler все технические проблемы остались в прошлом, и флагманские карты уже не требовали каких-либо компромиссов. Производство 28 нм кремниевых пластин было отлажено практически до идеала к весне 2013 года, и Nvidia занялась тем, что ей удавалось лучше всего за последние годы – улучшать то, что и раньше работало отлично.GTX 780 стала классическим примером того, как вчерашний флагман спускается на ступеньку ниже, и превращается в продукт для массового рынка – если в основе GTX 680 лежал полноформатный кристалл GK104, то в GTX 780 Nvidia использовала упрощенный GK110, на котором прежде уже выпустила полупрофессиональный GTX Titan.

NVidia GeForce GTX 780При этом разделение двух видеокарт оставалось очевидным – у GTX 780 разработчики отключили вычислительные конвейеры для двойных точных операций, оставив их GTX Titan с его ориентиром на профессиональный рынок. 780 было уготовано место #1 в игровых бенчмарках.И сомнений в техническом превосходстве GTX 780 не возникало – в полтора раза больше текстурных блоков, ROPов и видеопамяти, более широкая шина в 384 бита и новые технологии. Флагман второго поколения Kepler обошел GTX 680 на 30%, чего было достаточно для закрепления за собой статуса лидера рынка. Но у всего роста была своя цена – и помимо возросшего до 250 Вт энергопотребления фанаты NVidia были неприятно удивлены ценой в $650. NVidia хитро разыграла карты, присвоив новинке демократичный (на фоне GTX Titan) прайс, но при этом не скрывая желания побольше заработать. Да и помех этому не предвиделось - у AMD не было новых мощных видеокарт, поэтому команда Дженсена Хуанга наслаждалась высочайшей степенью свободы, обожанием прессы и геймеров по всему миру.Чтобы закрепить успех и увеличить продажи недешевого флагмана, зеленые впервые обращались к фанатам, использующим старые видеокарты верхнего сегмента – GTX 480 или GTX 280 – по сравнению с которыми производительность GTX 780 производила серьезное впечатление. Очевидно, что 30% прибавки для владельцев GTX 680 оказалось недостаточно, и пришлось подбирать сладкие речи для тех, кто не готов каждый год приобретать новый флагман.Именно для рефреша Kepler NVidia выпустила свою фирменную утилиту для записи геймплея и стримов Shadowplay, использующую кодек H.264. Благодаря появлению такой новинки многие могли позволить себе впервые записать игровые футажи или провести трансляцию в прямом эфире, используя только ресурсы GPU – хотя итоговое качество в значительном плане уступало «чистому» декодингу через CPU.Более доступная GTX 770 появилась на прилавках в конце мая-начале июня 2013 года, и была построена на полном чипе GK104 – том самом, который прежде был в основе GTX 680. На этот раз NVidia выжала из чипа всё, что возможно – и использовала полученную карту для конкуренции в ценовом сегменте $400.Иронично, но конкурентом новинки выступали уже видавшие виды HD 7970 и её «заряженная» версия в формате Ghz Edition. Несмотря на технологические преимущества, у GTX 770 были и свои недостатки – потребление, всего немногим ниже флагманской GTX 780 (с 250 до 230 Вт), а в дополнение к основной модели с 4 Гб видеопамяти в продаже была и чуть более доступная версия с 2 Гб, страдавшая от нехватки памяти уже тогда. Впрочем, на стороне AMD был не только более объемный буфер видеопамяти, но и фирменный игровой бандл Never Settle, в котором с покупкой 7970 игрок получал 4 отличных игры. NVidia, напротив, никаких наборов с бонусами не продумала – и быстро об этом пожалела.Игроки не ждали от AMD никаких сюрпризов на фоне Tahiti, но чудо всё-таки произошло.R9 290 – Горячие и знойные ГавайиНесмотря на то, что октябрьская презентация Hawaii включала целых пять видеокарт в обновленной брендовой линейке Radeon 200 (модели от бодрой R9 280Х до затычки R5 240), все они были ремаркировками чипов прошлого поколения. Казалось, разочарование неизбежно… но уже две недели спустя линейку пополнил совершенно новый, горячий и мощный чип Hawaii.Новый GPU стал логическим развитием предыдущего флагмана на базе Tahiti, и использовал обновленную архитектуру GCN 1.1 (остальные карты линейки Radeon 200 оставались отпрысками HD7000, и использовали оригинальную GCN 1.0). Новый флагманский чип получил 4 геометрических процессора (вместо 2 у Tahiti), а также в два раза больше ROPов (64 вместо 32). Число вычислительных блоков также возросло с 32 до 44, обещая прибавку «сырой» производительности до 40%.

AMD Radeon R9 290XПри этом для обеспечения стабильной производительности большинства видеокарт референсные модели R9 290X имели фиксированную буст-частоту в 1 ГГц, лишив надежд многочисленных оверкловеров-энтузиастов, выжимавших 20% дополнительной производительности из обычной HD 7970. Само собой, партнерские карты оказались куда интереснее – но и на рынке они появились значительно позже.Любопытно, что при общем увеличении размера кристалла AMD смогла обойтись без тяги к гигантизму - в сравнении с 352 мм2 Tahiti Hawaii увеличились в размере всего на 20% (438 мм2), при этом серьезно уплотнив упаковку блоков и других элементов. Во многом это стало возможным не только благодаря отлаженному до идеала 28-нм техпроцессу, но и основательной переработке шины памяти. Дело в том, что в случае с 7970 (и доработанной 280X) комплексная подсистема памяти была громоздкой, и занимала большую площадь на кристалле чипа.