[Python, Программирование, Лайфхаки для гиков] Как сделать полнотекстовую поисковую машину на 150 строках кода Python (перевод)

Автор

Сообщение

news_bot ®

Стаж: 8 лет

Сообщений: 27286

Полнотекстовый поиск — неотъемлемая часть нашей жизни. Разыскать нужные материалы в сервисе облачного хранения документов, найти фильм в Netflix, купить туалетную бумагу на Ozon или отыскать с помощью сервисов Google интересующую информацию в Интернете — наверняка вы сегодня уже не раз отправляли похожие запросы на поиск нужной информации в невообразимых объёмах неструктурированных данных. И что удивительнее всего — несмотря на то что вы осуществляли поиск среди миллионов (или даже миллиардов) записей, вы получали ответ за считанные миллисекунды. Специально к старту нового потока курса Fullstack-разработчик на Python в данной статье мы рассмотрим основные компоненты полнотекстовой поисковой машины и попытаемся создать систему, которая сможет за миллисекунды находить информацию в миллионах документов и ранжировать результаты по релевантности, причём всю систему можно воплотить всего в 150 строках кода на Python!ДанныеВесь код, использованный в данной статье, можно найти на Github. Здесь я приведу ссылки на фрагменты кода, и вы сами сможете попробовать с ним поработать. Весь пример можно запустить, установив файл requirements (pip install -r requirements.txt) и запустив на выполнение файл python run.py. Данная команда загрузит все данные и запустит пример поискового запроса с ранжированием и без ранжирования.Перед тем как начать создание поисковой машины, нужно подготовить полнотекстовые неструктурированные данные, в которых будет осуществляться поиск. Искать будем в аннотациях статей из английской Википедии. Это заархивированный с помощью gzip — утилиты сжатия и восстановления файлов — XML-файл размером около 785 Мбайт, содержащий приблизительно 6,27 миллионов аннотаций [1]. Для загрузки архивированного XML-файла я написал простую функцию, но вы можете поступить проще — загрузить его вручную.Подготовка данныхВсе аннотации хранятся в одном большом XML-файле. Аннотации в таком файле отделяются друг от друга элементом <doc> и выглядят примерно так (элементы, которые нас не интересуют, я опустил):

<doc>

<title>Wikipedia: London Beer Flood</title>

<url>https://en.wikipedia.org/wiki/London_Beer_Flood</url>

<abstract>The London Beer Flood was an accident at Meux & Co's Horse Shoe Brewery, London, on 17 October 1814. It took place when one of the wooden vats of fermenting porter burst.</abstract>

...

</doc>

Интерес для нас представляют следующие разделы: title, url abstract (сам текст аннотации). Чтобы было удобнее обращаться к данным, представим документы как класс данных Python. Добавим свойство, конкатенирующее заголовок и содержание аннотации. Код можно взять здесь.

from dataclasses import dataclass

@dataclass

class Abstract:

"""Wikipedia abstract"""

ID: int

title: str

abstract: str

url: str

@property

def fulltext(self):

return ' '.join([self.title, self.abstract])

Затем нужно извлечь данные из XML-файла, осуществить их синтаксический разбор и создать экземпляры нашего объекта Abstract. Весь заархивированный XML-файл загружать в память не нужно, будем работать с потоком данных [2]. Каждому документу присвоим собственный идентификатор (ID) согласно порядку загрузки (то есть первому документу присваивается ID=1, второму — ID=2 и т. д.). Код можно взять здесь.

import gzip

from lxml import etree

from search.documents import Abstract

def load_documents():

# open a filehandle to the gzipped Wikipedia dump

with gzip.open('data/enwiki.latest-abstract.xml.gz', 'rb') as f:

doc_id = 1

# iterparse will yield the entire `doc` element once it finds the

# closing `</doc>` tag

for _, element in etree.iterparse(f, events=('end',), tag='doc'):

title = element.findtext('./title')

url = element.findtext('./url')

abstract = element.findtext('./abstract')

yield Abstract(ID=doc_id, title=title, url=url, abstract=abstract)

doc_id += 1

# the `element.clear()` call will explicitly free up the memory

# used to store the element

element.clear()

ИндексированиеПолученные данные сохраняем в структуре данных, называемой «обращённый указатель», или «список документов». Полученная структура напоминает алфавитный указатель, который обычно приводится в конце книги, представляющий собой перечень встречающихся в книге соответствующих слов и понятий с указанием номеров страниц, на которых такие слова и понятия встречаются.

Так выглядит книжный алфавитный указатель Фактически мы создаём словарь, в котором будет проведено сопоставление всех слов нашего набора документов с идентификаторами документов, в которых встречаются эти слова. Выглядеть это будет примерно так:

{

...

"london": [5245250, 2623812, 133455, 3672401, ...],

"beer": [1921376, 4411744, 684389, 2019685, ...],

"flood": [3772355, 2895814, 3461065, 5132238, ...],

...

}

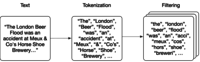

Обратите внимание, что в приведённом выше примере элементы словаря записаны строчными буквами. Перед созданием указателя мы должны разбить исходный текст на отдельные слова, или лексемы, то есть проанализировать текст. Сначала разобьём текст на отдельные слова (по-научному: выделим лексемы), а затем применим к лексемам ряд фильтров, например фильтр преобразования в нижний регистр или фильтр выделения основы слова (в принципе, фильтры можно и не применять), — это поможет получать более адекватные результаты поисковых запросов.

Выделение лексемАнализПрименим простейший способ выделения лексем: разобьём текст в местах, в которых встречаются пробелы. Затем к каждой лексеме применим пару фильтров: переведём текст лексемы в нижний регистр, удалим любые знаки препинания, исключим 25 наиболее распространённых английских слов (а также слово «википедия», так как оно встречается во всех заголовках всех аннотаций) и к каждому слову применим фильтр выделения основы слова (после этой операции разные формы слова, например, красный и краснота будут соответствовать одной и той же основе красн [3]).Функции выделения лексем и перевода в нижний регистр довольно просты:

import Stemmer

STEMMER = Stemmer.Stemmer('english')

def tokenize(text):

return text.split()

def lowercase_filter(text):

return [token.lower() for token in tokens]

def stem_filter(tokens):

return STEMMER.stemWords(tokens)

От знаков пунктуации избавиться также просто — к набору пунктуационных знаков применяется регулярное выражение:

import re

import string

PUNCTUATION = re.compile('[%s]' % re.escape(string.punctuation))

def punctuation_filter(tokens):

return [PUNCTUATION.sub('', token) for token in tokens]

Игнорируемые слова — это самые распространённые слова, которые, как мы полагаем, будут встречаться практически в каждом документе. Включение в указатель игнорируемых слов нежелательно, так как по поисковому запросу будет выдаваться практически каждый документ, и результат поиска станет малоинформативен (не говоря уже о том, что он займёт значительный объём памяти). Поэтому во время индексирования мы такие слова отфильтруем. В заголовках аннотаций статей Википедии содержится слово «Википедия», поэтому это слово мы также добавляем в список игнорируемых слов. В итоге мы внесли в список игнорируемых слов 25 самых распространённых слов английского языка, в том числе слово «Википедия».

# top 25 most common words in English and "wikipedia":

# https://en.wikipedia.org/wiki/Most_common_words_in_English

STOPWORDS = set(['the', 'be', 'to', 'of', 'and', 'a', 'in', 'that', 'have',

'I', 'it', 'for', 'not', 'on', 'with', 'he', 'as', 'you',

'do', 'at', 'this', 'but', 'his', 'by', 'from', 'wikipedia'])

def stopword_filter(tokens):

return [token for token in tokens if token not in STOPWORDS]

Применяя все описанные выше фильтры, мы создаём функцию анализа (analyze), которая будет применяться к тексту каждой аннотации; данная функция разбивает текст на отдельные слова (или лексемы), а затем последовательно применяет каждый фильтр к списку лексем. Порядок применения фильтров важен, так как в списке игнорируемых слов не выделены основы слов, поэтому фильтр stopword_filter нужно применить до фильтра stem_filter.

def analyze(text):

tokens = tokenize(text)

tokens = lowercase_filter(tokens)

tokens = punctuation_filter(tokens)

tokens = stopword_filter(tokens)

tokens = stem_filter(tokens)

return [token for token in tokens if token]

Индексирование набора документовСоздадим класс Index, в котором будет храниться указатель (index) и документы (documents). В словаре documents будут храниться классы данных по идентификатору (ID), а ключи указателя index будут представлять собой лексемы со значениями идентификаторов документов, в которых встречаются лексемы:

class Index:

def __init__(self):

self.index = {}

self.documents = {}

def index_document(self, document):

if document.ID not in self.documents:

self.documents[document.ID] = document

for token in analyze(document.fulltext):

if token not in self.index:

self.index[token] = set()

self.index[token].add(document.ID)

ПоискТеперь, когда все лексемы проиндексированы, задача выполнения поискового запроса превращается в задачу анализа текста запроса с помощью того же анализатора, который мы применили к документам; таким образом, мы получим лексемы, которые будут совпадать с лексемами, имеющимися в указателе. Для каждой лексемы осуществим поиск в словаре, выявим идентификаторы документов, в которых встречается такая лексема. Затем выявим идентификаторы документов во всех таких наборах (другими словами, чтобы документ соответствовал запросу, он должен содержать все лексемы, присутствующие в запросе). После этого возьмём итоговой список идентификаторов документов и выполним выборку данных из нашего хранилища документов [4].

def _results(self, analyzed_query):

return [self.index.get(token, set()) for token in analyzed_query]

def search(self, query):

"""

Boolean search; this will return documents that contain all words from the

query, but not rank them (sets are fast, but unordered).

"""

analyzed_query = analyze(query)

results = self._results(analyzed_query)

documents = [self.documents[doc_id] for doc_id in set.intersection(*results)]

return documents

In [1]: index.search('London Beer Flood')

search took 0.16307830810546875 milliseconds

Out[1]:

[Abstract(ID=1501027, title='Wikipedia: Horse Shoe Brewery', abstract='The Horse Shoe Brewery was an English brewery in the City of Westminster that was established in 1764 and became a major producer of porter, from 1809 as Henry Meux & Co. It was the site of the London Beer Flood in 1814, which killed eight people after a porter vat burst.', url='https://en.wikipedia.org/wiki/Horse_Shoe_Brewery'),

Abstract(ID=1828015, title='Wikipedia: London Beer Flood', abstract="The London Beer Flood was an accident at Meux & Co's Horse Shoe Brewery, London, on 17 October 1814. It took place when one of the wooden vats of fermenting porter burst.", url='https://en.wikipedia.org/wiki/London_Beer_Flood')]

Запросы получаются очень точными, особенно если строка запроса достаточно длинная (чем больше лексем содержит запрос, тем меньше вероятность выдачи документа, содержащего все такие лексемы). Функцию поиска можно оптимизировать, отдав предпочтение полноте, а не точности поиска, то есть пользователь может указать, что результатом поискового запроса может быть документ, в котором содержится лишь одна из указанных им лексем:

def search(self, query, search_type='AND'):

"""

Still boolean search; this will return documents that contain either all words

from the query or just one of them, depending on the search_type specified.

We are still not ranking the results (sets are fast, but unordered).

"""

if search_type not in ('AND', 'OR'):

return []

analyzed_query = analyze(query)

results = self._results(analyzed_query)

if search_type == 'AND':

# all tokens must be in the document

documents = [self.documents[doc_id] for doc_id in set.intersection(*results)]

if search_type == 'OR':

# only one token has to be in the document

documents = [self.documents[doc_id] for doc_id in set.union(*results)]

return documents

In [2]: index.search('London Beer Flood', search_type='OR')

search took 0.02816295623779297 seconds

Out[2]:

[Abstract(ID=5505026, title='Wikipedia: Addie Pryor', abstract='| birth_place = London, England', url='https://en.wikipedia.org/wiki/Addie_Pryor'),

Abstract(ID=1572868, title='Wikipedia: Tim Steward', abstract='|birth_place = London, United Kingdom', url='https://en.wikipedia.org/wiki/Tim_Steward'),

Abstract(ID=5111814, title='Wikipedia: 1877 Birthday Honours', abstract='The 1877 Birthday Honours were appointments by Queen Victoria to various orders and honours to reward and highlight good works by citizens of the British Empire. The appointments were made to celebrate the official birthday of the Queen, and were published in The London Gazette on 30 May and 2 June 1877.', url='https://en.wikipedia.org/wiki/1877_Birthday_Honours'),

...

In [3]: len(index.search('London Beer Flood', search_type='OR'))

search took 0.029065370559692383 seconds

Out[3]: 49627

РелевантностьС помощью элементарных команд Python мы создали довольно быстро работающую поисковую систему, но остался один аспект, которого явно не хватает в нашей маленькой поисковой машине, а именно не учтён принцип релевантности. Сейчас программа поиска составлена таким образом, что пользователь получает неупорядоченный список документов и должен сам выбирать из полученного списка действительно нужные ему документы. Но, если результатов очень много, справиться с такой задачей не под силу никакому пользователю (в нашем примере OR программа выдала почти 50 000 результатов).Вот тут-то и пригодится алгоритм ранжирования по релевантности, то есть алгоритм, который присваивал бы каждому документу собственный ранг — насколько точно документ соответствует запросу, и затем упорядочивал бы полученный список по таким рангам. Самый примитивный и простой способ присвоения ранга документу при выполнении запроса состоит в том, чтобы просто подсчитать, как часто в таком документе упоминается конкретное слово. Идея вроде бы логичная: чем чаще в документе упоминается термин, тем больше вероятность того, что это именно тот документ, который мы ищем!Частота вхождения терминовРасширим наш класс данных Abstract, чтобы можно было вычислять и сохранять частоту вхождения терминов в процессе индексирования. Соответственно, если нам потребуется ранжировать наш неупорядоченный список документов, у нас будет для этого вся нужная информация:

# in documents.py

from collections import Counter

from .analysis import analyze

@dataclass

class Abstract:

# snip

def analyze(self):

# Counter will create a dictionary counting the unique values in an array:

# {'london': 12, 'beer': 3, ...}

self.term_frequencies = Counter(analyze(self.fulltext))

def term_frequency(self, term):

return self.term_frequencies.get(term, 0)

При индексировании должен осуществляется подсчёт частот вхождения терминов:

# in index.py we add `document.analyze()

def index_document(self, document):

if document.ID not in self.documents:

self.documents[document.ID] = document

document.analyze()

Внесём изменения в функцию поиска таким образом, чтобы к документам результирующего набора можно было применить ранжирование. Выборку документов будем осуществлять с помощью одного и того же логического запроса из указателя и базы данных документов, а затем для каждого документа такого результирующего множества подсчитаем, сколько раз встречается в этом документе каждый термин.

def search(self, query, search_type='AND', rank=True):

# snip

if rank:

return self.rank(analyzed_query, documents)

return documents

def rank(self, analyzed_query, documents):

results = []

if not documents:

return results

for document in documents:

score = sum([document.term_frequency(token) for token in analyzed_query])

results.append((document, score))

return sorted(results, key=lambda doc: doc[1], reverse=True)

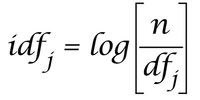

Обратная частота документовПолученная функция работает уже намного лучше, но у нее всё равно имеются определённые недостатки. Мы подразумевали, что при оценке релевантности запроса все термины запроса имеют один и тот же вес. Но, как нетрудно догадаться, при определении релевантности некоторые термины имеют либо крайне малую, либо вообще нулевую различающую способность; например, в наборе из большого количества документов, относящихся к пиву, термин «пиво» будет встречаться практически в каждом документе (ранее мы уже пытались обойти эту проблему, исключив из указателя 25 самых распространённых английских слов). Поиск слова «пиво» приведёт к тому, что мы получим лишь маловразумительный набор хаотично упорядоченных документов.Чтобы решить проблему, добавим в наш алгоритм определения релевантности ещё один компонент, занижающий в итоговом результате вес терминов, очень часто встречающихся в указателе. В принципе, можно было бы использовать значение частоты вхождения термина (то есть насколько часто такой термин встречается во всех документах), однако на практике вместо этого значения используется значение частоты документов (то есть какое количество документов в указателе содержат данный термин). Поскольку наша задача заключается в ранжировании именно документов, формировать статистику имеет смысл на уровне документов.Обратная частота документов для термина определяется делением количества документов (N) в указателе на количество документов, содержащих термин, и взятием логарифма полученного частного.

Обратная частота документов (IDF); формула взята из https://moz.com/blog/inverse-document-frequency-and...of-uniquenessПри ранжировании значение частоты термина умножается на значение обратной частоты документа, и, следовательно, документы, в которых присутствуют термины, редко встречающиеся в наборе документов, будут более релевантными [5]. Значение обратной частоты документов можно легко рассчитать по указателю:

# index.py

import math

def document_frequency(self, token):

return len(self.index.get(token, set()))

def inverse_document_frequency(self, token):

# Manning, Hinrich and Schütze use log10, so we do too, even though it

# doesn't really matter which log we use anyway

# https://nlp.stanford.edu/IR-book/html/htmledition/inverse-document-frequency-1.html

return math.log10(len(self.documents) / self.document_frequency(token))

def rank(self, analyzed_query, documents):

results = []

if not documents:

return results

for document in documents:

score = 0.0

for token in analyzed_query:

tf = document.term_frequency(token)

idf = self.inverse_document_frequency(token)

score += tf * idf

results.append((document, score))

return sorted(results, key=lambda doc: doc[1], reverse=True)

Будущая работа™Мы создали элементарную информационно-поисковую систему всего из нескольких десятков строчек кода Python! Код целиком приведён на Github. Также я написал вспомогательную функцию, загружающую аннотации статей Википедии и создающую указатель. Установите файл requirements, запустите его в выбранной вами консоли Python и получайте удовольствие от работы со структурами данных и операциями поиска.Данная статья написана с единственной целью — привести пример реализации концепции поиска и продемонстрировать, что поисковые запросы (даже с ранжированием) могут выполняться очень быстро (например, на своём ноутбуке с «медленным» Python я могу осуществлять поиск и ранжирование среди 6,27 миллионов документов). Статью ни в коем случае не следует рассматривать как инструкцию по созданию программного обеспечения промышленного уровня. Моя поисковая машина запускается полностью в памяти ноутбука, но такие библиотеки, как Lucene, используют сверхпроизводительные структуры данных и даже оптимизируют дисковые операции, а такие программные комплексы, как Elasticsearch и Solr, распространяют библиотеку Lucene на сотни, а иногда и тысячи машин.Но даже наш простенький алгоритм можно существенно улучшить. Например, мы молчаливо предполагали, что каждое поле документа вносит в релевантность одинаковый вклад, но, если поразмыслить, так быть не должно — ведь термин, присутствующий в заголовке, очевидно, должен иметь больший вес, чем термин, встречающийся в содержании аннотации. Другой перспективной идеей может стать более продвинутый синтаксический анализ запроса — должны ли совпадать все термины? только один термин? или несколько? Зная ответы на эти вопросы, можно повысить качество работы поисковых запросов. Также — почему бы не исключить из запроса определённые термины? почему бы не применить операции AND и OR к отдельным терминам? Можно ли сохранить указатель на диск и вывести его, таким образом, за пределы оперативной памяти ноутбука? Благодаря своей универсальности и распространённости, Python уже который год находится в топе языков программирования и де-факто стал основным языком для работы с данными. Если вы хотите расширить свои компетенции и освоить этот язык под руководством крутых менторов — приходите на курс Fullstack-разработчик на Python.

Узнайте, как прокачаться в других инженерных специальностях или освоить их с нуля:

- Курс "Python для веб-разработки"

- Профессия Data Scientist

- Профессия Data Analyst

- Курс по Data Engineering

Другие профессии и курсыПРОФЕССИИ

- Профессия Fullstack-разработчик на Python

- Профессия Java-разработчик

- Профессия QA-инженер на JAVA

- Профессия Frontend-разработчик

- Профессия Этичный хакер

- Профессия C++ разработчик

- Профессия Разработчик игр на Unity

- Профессия Веб-разработчик

- Профессия iOS-разработчик с нуля

- Профессия Android-разработчик с нуля

КУРСЫ

- Курс по Machine Learning

- Курс "Machine Learning и Deep Learning"

- Курс "Математика для Data Science"

- Курс "Математика и Machine Learning для Data Science"

- Курс "Алгоритмы и структуры данных"

- Курс по аналитике данных

- Курс по DevOps

- Аннотация — это, как правило, первый абзац или первая пара предложений статьи в Википедии. Полный объём заархивированного XML-файла составляет приблизительно 796 Мбайт. Если вы захотите самостоятельно поэкспериментировать с кодом, можно воспользоваться доступными архивами меньшего размера (с ограниченным количеством аннотаций); синтаксический разбор и индексирование XML-файла займут довольно большое время и потребуют значительных объёмов памяти.

- Весь набор данных и указатель будут храниться в памяти, поэтому нет нужды также хранить в памяти необработанные данные.

- Много ли преимуществ даёт фильтр выделения основы слова? Это тема для отдельного обсуждения. Применение такого фильтра позволит уменьшить общий размер указателя (то есть уменьшить количество уникальных слов), однако операция выделения основы слова базируется на эвристике, и мы, сами того не желая, можем отсеять потенциально ценную информацию. Например, если слова университет, универсальный, университеты и универсиада усечь до основы универс, мы потеряем способность различать значения этих слов, а это отрицательно скажется на релевантности. Более подробная информация о выделении основы слов (и лемматизации) приведена в этой отличной статье.

- При решении задачи мы используем оперативную память ноутбука. Но на практике применяется другой способ, не связанный с хранением указателя в памяти. Поисковая система Elasticsearch хранит данные в обычном текстовом формате JSON на диске, в самой библиотеке Lucene (базовой библиотеке поиска и индексирования) хранятся только индексированные данные. Многие другие поисковые системы просто возвращают упорядоченный список идентификаторов документов, который затем используется для извлечения и выдачи пользователям данных из базы данных или другого сервиса. Особенно это актуально для крупных корпораций, в которых полное реиндексирование всех данных обходится недёшево. Как правило, в поисковой системе хранятся только данные, связанные с обеспечением релевантности (а не атрибуты, используемые только для презентационных целей).

- Для более глубокого понимания алгоритма рекомендую ознакомиться со следующими публикациями: What is TF-IDF? и Term frequency and weighting

===========

Источник:

habr.com

===========

===========

Автор оригинала: Bart de Goede

===========Похожие новости:

- [Python, Data Mining, HTML, Визуализация данных] Сравнение ассортимента блюд трёх ресторанов Санкт-Петербурга

- [Программирование, Алгоритмы, Big Data] Пирамидальная сортировка, сортировка слиянием и выпуклая оболочка (перевод)

- [Программирование, Компиляторы, Управление разработкой] Какая «идеальная» цель развития у языков программирования?

- [Программирование, Алгоритмы, Учебный процесс в IT] Вебинар «Ускорение на простых типах данных и битовые операции»

- [C++, Системное программирование, C, Карьера в IT-индустрии] Альтернативное собеседование на позицию разработчика ПО

- [Читальный зал, Продвижение игр, Игры и игровые приставки, Лайфхаки для гиков] Почему стриминговая индустрия скоро достигнет оценки в 184 миллиарда долларов (перевод)

- [C++, Программирование микроконтроллеров] Разработка firmware на С++ словно игра в бисер. Как перестать динамически выделять память и начать жить

- [Python, Программирование, Проектирование и рефакторинг] Python & оптимизация времени и памяти

- [Научно-популярное, Физика, Астрономия] Как Земля движется в космосе? Теперь мы знаем это во всех масштабах (перевод)

- [Программирование, Java, Совершенный код, Проектирование и рефакторинг] Как извлечь пользу из статической типизации

Теги для поиска: #_python, #_programmirovanie (Программирование), #_lajfhaki_dlja_gikov (Лайфхаки для гиков), #_skillfactory, #_programmirovanie (программирование), #_polnotekstovyj_poisk (полнотекстовый поиск), #_python, #_lajfhaki_dlja_gikov (лайфхаки для гиков), #_blog_kompanii_skillfactory (

Блог компании SkillFactory

), #_python, #_programmirovanie (

Программирование

), #_lajfhaki_dlja_gikov (

Лайфхаки для гиков

)

Вы не можете начинать темы

Вы не можете отвечать на сообщения

Вы не можете редактировать свои сообщения

Вы не можете удалять свои сообщения

Вы не можете голосовать в опросах

Вы не можете прикреплять файлы к сообщениям

Вы не можете скачивать файлы

Текущее время: 11-Фев 12:04

Часовой пояс: UTC + 5

| Автор | Сообщение |

|---|---|

|

news_bot ®

Стаж: 8 лет |

|

Полнотекстовый поиск — неотъемлемая часть нашей жизни. Разыскать нужные материалы в сервисе облачного хранения документов, найти фильм в Netflix, купить туалетную бумагу на Ozon или отыскать с помощью сервисов Google интересующую информацию в Интернете — наверняка вы сегодня уже не раз отправляли похожие запросы на поиск нужной информации в невообразимых объёмах неструктурированных данных. И что удивительнее всего — несмотря на то что вы осуществляли поиск среди миллионов (или даже миллиардов) записей, вы получали ответ за считанные миллисекунды. Специально к старту нового потока курса Fullstack-разработчик на Python в данной статье мы рассмотрим основные компоненты полнотекстовой поисковой машины и попытаемся создать систему, которая сможет за миллисекунды находить информацию в миллионах документов и ранжировать результаты по релевантности, причём всю систему можно воплотить всего в 150 строках кода на Python!ДанныеВесь код, использованный в данной статье, можно найти на Github. Здесь я приведу ссылки на фрагменты кода, и вы сами сможете попробовать с ним поработать. Весь пример можно запустить, установив файл requirements (pip install -r requirements.txt) и запустив на выполнение файл python run.py. Данная команда загрузит все данные и запустит пример поискового запроса с ранжированием и без ранжирования.Перед тем как начать создание поисковой машины, нужно подготовить полнотекстовые неструктурированные данные, в которых будет осуществляться поиск. Искать будем в аннотациях статей из английской Википедии. Это заархивированный с помощью gzip — утилиты сжатия и восстановления файлов — XML-файл размером около 785 Мбайт, содержащий приблизительно 6,27 миллионов аннотаций [1]. Для загрузки архивированного XML-файла я написал простую функцию, но вы можете поступить проще — загрузить его вручную.Подготовка данныхВсе аннотации хранятся в одном большом XML-файле. Аннотации в таком файле отделяются друг от друга элементом <doc> и выглядят примерно так (элементы, которые нас не интересуют, я опустил): <doc>

<title>Wikipedia: London Beer Flood</title> <url>https://en.wikipedia.org/wiki/London_Beer_Flood</url> <abstract>The London Beer Flood was an accident at Meux & Co's Horse Shoe Brewery, London, on 17 October 1814. It took place when one of the wooden vats of fermenting porter burst.</abstract> ... </doc> from dataclasses import dataclass

@dataclass class Abstract: """Wikipedia abstract""" ID: int title: str abstract: str url: str @property def fulltext(self): return ' '.join([self.title, self.abstract]) import gzip

from lxml import etree from search.documents import Abstract def load_documents(): # open a filehandle to the gzipped Wikipedia dump with gzip.open('data/enwiki.latest-abstract.xml.gz', 'rb') as f: doc_id = 1 # iterparse will yield the entire `doc` element once it finds the # closing `</doc>` tag for _, element in etree.iterparse(f, events=('end',), tag='doc'): title = element.findtext('./title') url = element.findtext('./url') abstract = element.findtext('./abstract') yield Abstract(ID=doc_id, title=title, url=url, abstract=abstract) doc_id += 1 # the `element.clear()` call will explicitly free up the memory # used to store the element element.clear()  Так выглядит книжный алфавитный указатель Фактически мы создаём словарь, в котором будет проведено сопоставление всех слов нашего набора документов с идентификаторами документов, в которых встречаются эти слова. Выглядеть это будет примерно так: {

... "london": [5245250, 2623812, 133455, 3672401, ...], "beer": [1921376, 4411744, 684389, 2019685, ...], "flood": [3772355, 2895814, 3461065, 5132238, ...], ... }  Выделение лексемАнализПрименим простейший способ выделения лексем: разобьём текст в местах, в которых встречаются пробелы. Затем к каждой лексеме применим пару фильтров: переведём текст лексемы в нижний регистр, удалим любые знаки препинания, исключим 25 наиболее распространённых английских слов (а также слово «википедия», так как оно встречается во всех заголовках всех аннотаций) и к каждому слову применим фильтр выделения основы слова (после этой операции разные формы слова, например, красный и краснота будут соответствовать одной и той же основе красн [3]).Функции выделения лексем и перевода в нижний регистр довольно просты: import Stemmer

STEMMER = Stemmer.Stemmer('english') def tokenize(text): return text.split() def lowercase_filter(text): return [token.lower() for token in tokens] def stem_filter(tokens): return STEMMER.stemWords(tokens) import re

import string PUNCTUATION = re.compile('[%s]' % re.escape(string.punctuation)) def punctuation_filter(tokens): return [PUNCTUATION.sub('', token) for token in tokens] # top 25 most common words in English and "wikipedia":

# https://en.wikipedia.org/wiki/Most_common_words_in_English STOPWORDS = set(['the', 'be', 'to', 'of', 'and', 'a', 'in', 'that', 'have', 'I', 'it', 'for', 'not', 'on', 'with', 'he', 'as', 'you', 'do', 'at', 'this', 'but', 'his', 'by', 'from', 'wikipedia']) def stopword_filter(tokens): return [token for token in tokens if token not in STOPWORDS] def analyze(text):

tokens = tokenize(text) tokens = lowercase_filter(tokens) tokens = punctuation_filter(tokens) tokens = stopword_filter(tokens) tokens = stem_filter(tokens) return [token for token in tokens if token] class Index:

def __init__(self): self.index = {} self.documents = {} def index_document(self, document): if document.ID not in self.documents: self.documents[document.ID] = document for token in analyze(document.fulltext): if token not in self.index: self.index[token] = set() self.index[token].add(document.ID) def _results(self, analyzed_query):

return [self.index.get(token, set()) for token in analyzed_query] def search(self, query): """ Boolean search; this will return documents that contain all words from the query, but not rank them (sets are fast, but unordered). """ analyzed_query = analyze(query) results = self._results(analyzed_query) documents = [self.documents[doc_id] for doc_id in set.intersection(*results)] return documents In [1]: index.search('London Beer Flood') search took 0.16307830810546875 milliseconds Out[1]: [Abstract(ID=1501027, title='Wikipedia: Horse Shoe Brewery', abstract='The Horse Shoe Brewery was an English brewery in the City of Westminster that was established in 1764 and became a major producer of porter, from 1809 as Henry Meux & Co. It was the site of the London Beer Flood in 1814, which killed eight people after a porter vat burst.', url='https://en.wikipedia.org/wiki/Horse_Shoe_Brewery'), Abstract(ID=1828015, title='Wikipedia: London Beer Flood', abstract="The London Beer Flood was an accident at Meux & Co's Horse Shoe Brewery, London, on 17 October 1814. It took place when one of the wooden vats of fermenting porter burst.", url='https://en.wikipedia.org/wiki/London_Beer_Flood')] def search(self, query, search_type='AND'):

""" Still boolean search; this will return documents that contain either all words from the query or just one of them, depending on the search_type specified. We are still not ranking the results (sets are fast, but unordered). """ if search_type not in ('AND', 'OR'): return [] analyzed_query = analyze(query) results = self._results(analyzed_query) if search_type == 'AND': # all tokens must be in the document documents = [self.documents[doc_id] for doc_id in set.intersection(*results)] if search_type == 'OR': # only one token has to be in the document documents = [self.documents[doc_id] for doc_id in set.union(*results)] return documents In [2]: index.search('London Beer Flood', search_type='OR') search took 0.02816295623779297 seconds Out[2]: [Abstract(ID=5505026, title='Wikipedia: Addie Pryor', abstract='| birth_place = London, England', url='https://en.wikipedia.org/wiki/Addie_Pryor'), Abstract(ID=1572868, title='Wikipedia: Tim Steward', abstract='|birth_place = London, United Kingdom', url='https://en.wikipedia.org/wiki/Tim_Steward'), Abstract(ID=5111814, title='Wikipedia: 1877 Birthday Honours', abstract='The 1877 Birthday Honours were appointments by Queen Victoria to various orders and honours to reward and highlight good works by citizens of the British Empire. The appointments were made to celebrate the official birthday of the Queen, and were published in The London Gazette on 30 May and 2 June 1877.', url='https://en.wikipedia.org/wiki/1877_Birthday_Honours'), ... In [3]: len(index.search('London Beer Flood', search_type='OR')) search took 0.029065370559692383 seconds Out[3]: 49627 # in documents.py

from collections import Counter from .analysis import analyze @dataclass class Abstract: # snip def analyze(self): # Counter will create a dictionary counting the unique values in an array: # {'london': 12, 'beer': 3, ...} self.term_frequencies = Counter(analyze(self.fulltext)) def term_frequency(self, term): return self.term_frequencies.get(term, 0) # in index.py we add `document.analyze()

def index_document(self, document): if document.ID not in self.documents: self.documents[document.ID] = document document.analyze() def search(self, query, search_type='AND', rank=True):

# snip if rank: return self.rank(analyzed_query, documents) return documents def rank(self, analyzed_query, documents): results = [] if not documents: return results for document in documents: score = sum([document.term_frequency(token) for token in analyzed_query]) results.append((document, score)) return sorted(results, key=lambda doc: doc[1], reverse=True)  Обратная частота документов (IDF); формула взята из https://moz.com/blog/inverse-document-frequency-and...of-uniquenessПри ранжировании значение частоты термина умножается на значение обратной частоты документа, и, следовательно, документы, в которых присутствуют термины, редко встречающиеся в наборе документов, будут более релевантными [5]. Значение обратной частоты документов можно легко рассчитать по указателю: # index.py

import math def document_frequency(self, token): return len(self.index.get(token, set())) def inverse_document_frequency(self, token): # Manning, Hinrich and Schütze use log10, so we do too, even though it # doesn't really matter which log we use anyway # https://nlp.stanford.edu/IR-book/html/htmledition/inverse-document-frequency-1.html return math.log10(len(self.documents) / self.document_frequency(token)) def rank(self, analyzed_query, documents): results = [] if not documents: return results for document in documents: score = 0.0 for token in analyzed_query: tf = document.term_frequency(token) idf = self.inverse_document_frequency(token) score += tf * idf results.append((document, score)) return sorted(results, key=lambda doc: doc[1], reverse=True)  Узнайте, как прокачаться в других инженерных специальностях или освоить их с нуля:

=========== Источник: habr.com =========== =========== Автор оригинала: Bart de Goede ===========Похожие новости:

Блог компании SkillFactory ), #_python, #_programmirovanie ( Программирование ), #_lajfhaki_dlja_gikov ( Лайфхаки для гиков ) |

|

Вы не можете начинать темы

Вы не можете отвечать на сообщения

Вы не можете редактировать свои сообщения

Вы не можете удалять свои сообщения

Вы не можете голосовать в опросах

Вы не можете прикреплять файлы к сообщениям

Вы не можете скачивать файлы

Вы не можете отвечать на сообщения

Вы не можете редактировать свои сообщения

Вы не можете удалять свои сообщения

Вы не можете голосовать в опросах

Вы не можете прикреплять файлы к сообщениям

Вы не можете скачивать файлы

Текущее время: 11-Фев 12:04

Часовой пояс: UTC + 5