[Машинное обучение] Измерение гендерных корреляций в предобученных NLP-моделях (перевод)

Автор

Сообщение

news_bot ®

Стаж: 7 лет 11 месяцев

Сообщений: 27286

За последние несколько лет были сделаны значительные успехи в области обработки естественного языка (NLP), где такие модели, как BERT, ALBERT, ELECTRA и XLNet достигли поразительной точности (accuracy) в различных задачах. Во время предварительного обучения (pre-training) на основе обширного корпуса текстов (например, Википедии) формируются векторные представления, которые получают путем маскирования слов и попыток их предсказать (т.н. маскированное языковое моделирование). Получившиеся представления кодируют большой объем информации о языке и отношениях между понятиями, например, между хирургом и скальпелем. Далее начинается второй этап обучения – тонкая настройка (fine-tuning) – на котором модель использует заточенные под определенную задачу данные для того, чтобы с помощью общих предобученных представлений научиться выполнять конкретные задачи вроде классификации. Учитывая широкое использования подобных моделей в разных NLP задачах, критически важно понимать, какая информация в них содержится и как любые выученные отношения влияют на результаты модели в ее приложениях, чтобы обеспечить их соответствие Принципам искусственного интеллекта (ИИ).

В статье «Измерение гендерных корреляций в предобученных NLP-моделях» представляется исследование модели BERT и его облегченного собрата ALBERT в поисках отношений, связанных с гендером, и формулируется ряд лучших практик для использования предобученных языковых моделей. Авторы представляют экспериментальные результаты в виде публичных весов модели и исследовательского набора данных, чтобы продемонстрировать применение лучших практик и предоставить основу для дальнейшего изучения параметров, выходящего за рамки данной работы. Также авторы планируют выложить набор весов Zari, в котором снижено число гендерных корреляций, но сохранено высокое качество на стандартных задачах NLP.

Измерение корреляций

Для того, чтобы понять, как корреляции в предобученных представлениях могут влиять на метрики в прикладных задачах, авторы применили набор разнообразных оценивающих метрик для изучения гендерных представлений. Один из таких тестов основан на задаче разрешения кореференции, смысл которой состоит в способности модели понимать антецедента местоимения в предложении. Например, в следующем предложении модель должна распознать, что his («его») относится к nurse (в данном случае «медбрат»), а не к patient («пациент»).

Классическая академическая формулировка этого задания – тест OntoNotes (Hovy et al., 2006). На этих данных авторы оценивали с помощью F1-меры, насколько точно модель справляется с разрешением кореференции (как в Tenney et al. 2019). Так как OntoNotes представляет только одно распределение данных, авторы также рассмотрели бенчмарк WinoGender, который предоставляет дополнительный набор сбалансированных данных, составленный для нахождения случаев, когда ассоциативные связи модели между гендером и профессией способствуют неправильному разрешению кореференции. Высокие (близкие к 1) значения метрики WinoGender означают, что модель основывается на нормативных ассоциациях между полом и профессией (т.е. относит слово nurse к человеку женского пола, а не мужского). Когда предсказание модели не имеет никакой устойчивой корреляции пола и профессии, метрика равна нулю, что означает, что модель предсказывает на основе какой-то другой информации, например структуры или семантики предложения.

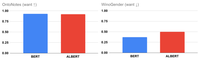

Метрики BERT и ALBERT на заданиях OntoNotes (точность) и WinoGender (гендерные корреляции). Низкие значения метрики WinoGender означают, что модель в своих предсказаниях в первую очередь руководствуется корреляциями, отличными от гендерных.

Настоящее исследование демонстрирует, что ни большая модель (Large) BERT, ни общедоступная модель ALBERT не достигают нулевого значения на примерах из WinoGender, несмотря на впечатляющие (близкие к 100%) показатели точности (accuracy) на задании OntoNotes. По меньшей мере отчасти это можно объяснить тем, что модель руководствуется преимущественно гендерными корреляциями в своих предсказаниях. Это неудивительно: существует ряд ключей к пониманию текста, и общая модель может воспринимать некоторые или даже все из них. К этому следует отнестись внимательно, т.к. крайне нежелательно, чтобы модель делала предсказания, основываясь преимущественно на гендерных корреляциях, а не на свидетельствах, встреченных в тексте на входе модели.

Лучшие практики

Возможное влияние нежелательных корреляций на результат работы модели в прикладных задачах ставит перед авторами вопрос: что можно предпринять при разработке NLP-моделей для снижения риска подобного влияния?

- Измеряйте нежелательные корреляции: Качество модели может быть измерено с помощью метрик точности, но они оценивают результаты только в одной плоскости, особенно если тестовые данные из того же распределения, что и данные для обучения. Например, веса BERT и ALBERT всего на 1% отличаются по метрике точности, однако на целых 26% по степени использования гендерных корреляций для разрешения кореференции. Эта разница может иметь большое значения в некоторых задачах: так, выбор модели с наименьшим значением метрики WinoGender может быть более предпочтителен в приложениях, где есть тексты о людях, профессии которых могут не соответствовать исторически сложившимся социальным нормам, таких, как, например, медбрат (male nurse).

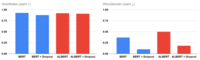

- Будьте осторожны при внесении на первый взгляд безобидных изменений в конфигурацию: Процесс обучения нейронных сетей регулируется множеством гиперпараметров, которые обычно подбираются для наилучшего достижения целей обучения. И хотя выбор конфигурации обычно кажется безобидным, авторы обнаружили, что он может значительно влиять на гендерные корреляции, как в лучшую, так и в худшую сторону. Это справедливо, например, в случае с дропаут-регуляризацией (dropout regularization), которая используется для снижения переобучения больших моделей: при увеличении показателя дропаута (dropout rate) в предварительном обучении BERT и ALBERT, наблюдается значительное снижение показателя гендерных корреляций даже после тонкой настройки. Это означает, что простым изменением конфигурации можно снизить риск нежелательных корреляций, однако это также демонстрирует, что нужно внимательно относиться к любым изменениям в модели.

- Используйте возможности для снижения нежелательных последствий: Еще одним следствием возможного неожиданного влияния дропаута на гендерные корреляции является возможность использования универсальных методов для уменьшения непреднамеренных корреляций: так, в ходе своего исследования авторы выяснили, что увеличение показателя дропаута позволило модели лучше справляться с примерами WinoGender без уточнения вручную каких-либо параметров задачи или изменения этапа тонкой настройки. К сожалению, на OntoNotes с увеличением показателя дропаута точность начинает падать (что можно наблюдать в результатах BERT'а), однако сама возможность снижения нежелательных последствий на этапе предварительного обучения, когда изменения в конфигурации могут привести к улучшению модели без необходимости внесения каких-либо дополнительных изменений для решения конкретных задач, кажется очень перспективной. Авторы рассмотрели аугментацию контрфактическими данными как еще одну стратегию уменьшения нежелательных последствий с различными условиями (см. статью).

Что дальше

Авторы считают, что эти передовые методики являются отправной точкой для разработки надежных NLP-систем, которые хорошо работают в самом широком диапазоне языкового окружения и приложений. Конечно, одних этих техник недостаточно для выявления и устранения всех потенциальных проблем. Любая модель, развернутая в реальных условиях, должна пройти тщательное тестирование, в котором учитываются различные способы ее использования и принимаются меры для обеспечения соответствия ее работы этическим нормам, таким как Принципы ИИ. Авторы с нетерпением ждут развития систем оценивания и данных, которые станут более обширными и инклюзивными, чтобы охватить множество вариантов использования языковых моделей и широкий круг людей, которым они стремятся служить.

Авторы

- Авторы оригинала — Kellie Webster

- Перевод — Смирнова Екатерина

- Редактирование и вёрстка — Шкарин Сергей

===========

Источник:

habr.com

===========

===========

Автор оригинала: Kellie Webster

===========Похожие новости:

- [Машинное обучение, Робототехника, Искусственный интеллект, Транспорт, Будущее здесь] “Водитель, вы — слабое звено”: новая разработка Honda

- [Программирование, Машинное обучение] Ранжирование признаков с помощью Recursive Feature Elimination в Scikit-Learn (перевод)

- [Информационная безопасность, Обработка изображений, Машинное обучение, Искусственный интеллект] Насколько неуязвим искусственный интеллект?

- [Программирование, Машинное обучение, Искусственный интеллект, Голосовые интерфейсы] Open Source синтез речи SOVA

- [Open source, Машинное обучение, Искусственный интеллект] DeepMind открыла код среды Lab2D для обучения нейросетей

- [Машинное обучение, Статистика в IT, Софт] Как правильно рассчитать ROI в RPA

- [ReactJS, Машинное обучение, TensorFlow] Transfer Learning с использованием TensorFlow.JS

- [Алгоритмы, Машинное обучение, Искусственный интеллект, Будущее здесь] AI, который не просит хлеба

- [Python, Алгоритмы, Машинное обучение, Искусственный интеллект, Data Engineering] Умная нормализация данных: категориальные и порядковые данные, “парные” признаки

- [Машинное обучение, Искусственный интеллект, Звук, Будущее здесь] Hey, Google: умные устройства будут активироваться без команд

Теги для поиска: #_mashinnoe_obuchenie (Машинное обучение), #_nlp, #_gendered_correlations, #_bert, #_mashinnoe_obuchenie (

Машинное обучение

)

Вы не можете начинать темы

Вы не можете отвечать на сообщения

Вы не можете редактировать свои сообщения

Вы не можете удалять свои сообщения

Вы не можете голосовать в опросах

Вы не можете прикреплять файлы к сообщениям

Вы не можете скачивать файлы

Текущее время: 14-Янв 09:58

Часовой пояс: UTC + 5

| Автор | Сообщение |

|---|---|

|

news_bot ®

Стаж: 7 лет 11 месяцев |

|

|

За последние несколько лет были сделаны значительные успехи в области обработки естественного языка (NLP), где такие модели, как BERT, ALBERT, ELECTRA и XLNet достигли поразительной точности (accuracy) в различных задачах. Во время предварительного обучения (pre-training) на основе обширного корпуса текстов (например, Википедии) формируются векторные представления, которые получают путем маскирования слов и попыток их предсказать (т.н. маскированное языковое моделирование). Получившиеся представления кодируют большой объем информации о языке и отношениях между понятиями, например, между хирургом и скальпелем. Далее начинается второй этап обучения – тонкая настройка (fine-tuning) – на котором модель использует заточенные под определенную задачу данные для того, чтобы с помощью общих предобученных представлений научиться выполнять конкретные задачи вроде классификации. Учитывая широкое использования подобных моделей в разных NLP задачах, критически важно понимать, какая информация в них содержится и как любые выученные отношения влияют на результаты модели в ее приложениях, чтобы обеспечить их соответствие Принципам искусственного интеллекта (ИИ). В статье «Измерение гендерных корреляций в предобученных NLP-моделях» представляется исследование модели BERT и его облегченного собрата ALBERT в поисках отношений, связанных с гендером, и формулируется ряд лучших практик для использования предобученных языковых моделей. Авторы представляют экспериментальные результаты в виде публичных весов модели и исследовательского набора данных, чтобы продемонстрировать применение лучших практик и предоставить основу для дальнейшего изучения параметров, выходящего за рамки данной работы. Также авторы планируют выложить набор весов Zari, в котором снижено число гендерных корреляций, но сохранено высокое качество на стандартных задачах NLP. Измерение корреляций Для того, чтобы понять, как корреляции в предобученных представлениях могут влиять на метрики в прикладных задачах, авторы применили набор разнообразных оценивающих метрик для изучения гендерных представлений. Один из таких тестов основан на задаче разрешения кореференции, смысл которой состоит в способности модели понимать антецедента местоимения в предложении. Например, в следующем предложении модель должна распознать, что his («его») относится к nurse (в данном случае «медбрат»), а не к patient («пациент»).  Классическая академическая формулировка этого задания – тест OntoNotes (Hovy et al., 2006). На этих данных авторы оценивали с помощью F1-меры, насколько точно модель справляется с разрешением кореференции (как в Tenney et al. 2019). Так как OntoNotes представляет только одно распределение данных, авторы также рассмотрели бенчмарк WinoGender, который предоставляет дополнительный набор сбалансированных данных, составленный для нахождения случаев, когда ассоциативные связи модели между гендером и профессией способствуют неправильному разрешению кореференции. Высокие (близкие к 1) значения метрики WinoGender означают, что модель основывается на нормативных ассоциациях между полом и профессией (т.е. относит слово nurse к человеку женского пола, а не мужского). Когда предсказание модели не имеет никакой устойчивой корреляции пола и профессии, метрика равна нулю, что означает, что модель предсказывает на основе какой-то другой информации, например структуры или семантики предложения.  Метрики BERT и ALBERT на заданиях OntoNotes (точность) и WinoGender (гендерные корреляции). Низкие значения метрики WinoGender означают, что модель в своих предсказаниях в первую очередь руководствуется корреляциями, отличными от гендерных. Настоящее исследование демонстрирует, что ни большая модель (Large) BERT, ни общедоступная модель ALBERT не достигают нулевого значения на примерах из WinoGender, несмотря на впечатляющие (близкие к 100%) показатели точности (accuracy) на задании OntoNotes. По меньшей мере отчасти это можно объяснить тем, что модель руководствуется преимущественно гендерными корреляциями в своих предсказаниях. Это неудивительно: существует ряд ключей к пониманию текста, и общая модель может воспринимать некоторые или даже все из них. К этому следует отнестись внимательно, т.к. крайне нежелательно, чтобы модель делала предсказания, основываясь преимущественно на гендерных корреляциях, а не на свидетельствах, встреченных в тексте на входе модели. Лучшие практики Возможное влияние нежелательных корреляций на результат работы модели в прикладных задачах ставит перед авторами вопрос: что можно предпринять при разработке NLP-моделей для снижения риска подобного влияния?

Что дальше Авторы считают, что эти передовые методики являются отправной точкой для разработки надежных NLP-систем, которые хорошо работают в самом широком диапазоне языкового окружения и приложений. Конечно, одних этих техник недостаточно для выявления и устранения всех потенциальных проблем. Любая модель, развернутая в реальных условиях, должна пройти тщательное тестирование, в котором учитываются различные способы ее использования и принимаются меры для обеспечения соответствия ее работы этическим нормам, таким как Принципы ИИ. Авторы с нетерпением ждут развития систем оценивания и данных, которые станут более обширными и инклюзивными, чтобы охватить множество вариантов использования языковых моделей и широкий круг людей, которым они стремятся служить. Авторы

=========== Источник: habr.com =========== =========== Автор оригинала: Kellie Webster ===========Похожие новости:

Машинное обучение ) |

|

Вы не можете начинать темы

Вы не можете отвечать на сообщения

Вы не можете редактировать свои сообщения

Вы не можете удалять свои сообщения

Вы не можете голосовать в опросах

Вы не можете прикреплять файлы к сообщениям

Вы не можете скачивать файлы

Вы не можете отвечать на сообщения

Вы не можете редактировать свои сообщения

Вы не можете удалять свои сообщения

Вы не можете голосовать в опросах

Вы не можете прикреплять файлы к сообщениям

Вы не можете скачивать файлы

Текущее время: 14-Янв 09:58

Часовой пояс: UTC + 5