[Машинное обучение] Последовательное глубокое обучение для мониторинга кредитных рисков с использованием табличных финансовых данных (перевод)

Автор

Сообщение

news_bot ®

Стаж: 7 лет 11 месяцев

Сообщений: 27286

Аннотация Машинное обучение играет важную роль в предотвращении финансовых потерь в банковской отрасли. Возможно, наиболее актуальной задачей прогнозирования, является оценка кредитного риска (риска дефолта по долгу). Такие риски могут привести к потерям в миллиарды долларов ежегодно. Сегодня большая часть выгод от машинного обучения в проблеме прогнозирования кредитного риска обусловлена моделями дерева решений с градиентным усилением. Тем не менее, эти выгоды начинают снижаться, если не поддерживаются новыми источниками данных и/или высокотехнологичных, гибких функций. В этой статье мы представляем наши попытки создать новый подход оценки кредитного риска с использованием глубокого обучения, который не предполагает сложного мониторинга, не опирается на новые входные данные модели. Мы предлагаем новые методы выборки транзакций по кредитным картам для использования с глубокими рекуррентными и причинно-следственными сверточными нейронными сетями, которые используют временные последовательности финансовых данных, без особых требований к ресурсам. Показываем, что наш последовательный подход к глубокому обучению с использованием временной сверточной сети превзошел эталонную непоследовательную древовидную модель, добившись значительной финансовой экономии и раннего обнаружения кредитного риска. Мы также демонстрируем потенциал нашего подхода для его использования в производственной среде, где предлагаемая методика выборки позволяет эффективно хранить последовательности в памяти, используя их для быстрого онлайн-обучения и продукций. KEYWORDS credit risk, tabular data, credit card transactions, recurrent neural networks, temporal convolutional networks 1. ВВЕДЕНИЕ Когда заемщики банка попадают в кризисную ситуацию, раннее обнаружение даже небольших изменений, уязвимостей в их финансовом положении может существенно уменьшить убытки банка, если своевременно принять превентивные меры (например, снижение кредитного лимита заемщика). Фактически, непрерывный мониторинг кредитного риска является неотъемлемой частью большинства стратегий снижения убытков в банковской отрасли [24]. Современные модели кредитного скоринга для оценки риска обычно опираются на деревья решений с градиентным усилением (GBDTs), которые обеспечивают ряд преимуществ по сравнению с традиционными методами, такими как логистическая регрессия [10]. Например, взаимодействия между переменными автоматически генерируются в процессе усиления связей и комбинируются для повышения точности прогнозирования. Кроме этого, этапы предварительной обработки, такие как заполнение пропущенных значений и отбраковка данных, как правило, не требуются. Однако эти модели также имеют определенные ограничения. Во-первых, повышение производительности обычно достигается за счет разработки функций для ввода новых переменных, основанных на обширных знаниях и опыте предметной области. Во-вторых, древовидные модели неполно используют предысторию в данных. Наконец, они не могут быть использованы в режиме онлайн-обучения (где данные становятся доступны последовательно) из-за их ограниченных возможностей по обновлению, таким как изменение разбиений, без просмотра всего набора данных с самого начала (например, [6]). Чтобы преодолеть ограничения традиционного древовидного подхода, мы исследовали несколько методов глубокого обучения для оценки кредитного риска и создали уникальный метод генерации последовательностей операций по кредитным картам, который изучает годовую кредитную историю заемщиков. Применяя те же входные характеристики, что и эталонная модель GBDT, мы показываем, что наш последовательный подход к глубокому обучению с использованием временной сверточной сети (TCN) обеспечивает явные преимущества по сравнению с древовидной методикой. Основное улучшение заключается в том, что производительность существенно возрастает, что приводит к значительной финансовой экономии и более раннему выявлению кредитного риска. Мы также демонстрируем потенциал использования нашего подхода в онлайн-обучении для мониторинга кредитного риска без внесения существенных изменений в учебный процесс. Предыдущие исследования применения глубокого обучения к табличным данным по транзакциям с помощью кредитных карт были направлены на обнаружение мошенничества [9, 23], заявки на получение кредита [3, 26] и мониторинг кредитных рисков [1,19]. Наша работа отличается от предыдущей работы по глубокому обучению мониторингу кредитного риска тем, что она выходит за рамки простых многослойных сетей персептронов и включает последовательные методы, такие как рекуррентные нейронные сети (RNN) и TCN, которые явно используют доступные данные предыстории. Кроме того, мы представляем новый метод выборки для создания последовательностей транзакций, который устраняет резкие различия в длине кредитной истории участников в течение всего года. Преимущества использования выборочных транзакций из длительного временного горизонта, в отличие от общего количества транзакций, заключаются в том, что это уменьшает «белый шум» в данных, требования к памяти и времени обучения/логического вывода. Следовательно, модель может изучать, обобщать ранние предупреждающие признаки финансовых риск-операций. При этом сохраняется возможность работать почти в реальном времени во время онлайн-мониторинга кредита. Основные результаты, представленные в этой статье, заключаются в следующем. Сначала мы показываем потенциал последовательного глубокого обучения для улучшения нашей текущей системы кредитного скоринга с помощью автономного анализа, который выявил значительное сокращение финансовых потерь (десятки миллионов долларов США ежегодно) и возможности повышения скорости раннего выявления риск-ситуаций. Мы также разработали метод выборки для генерации последовательностей транзакций в течение целого года, который позволяет модели изучать долгосрочные поведенческие тенденции и устраняет необходимость загружать и обрабатывать сотни миллиардов транзакций по кредитным картам заемщиков ежегодно. Наконец, мы демонстрируем, что онлайн-обучение может быть применено к нашему подходу и обеспечивает более высокую производительность по сравнению со случайной повторной инициализацией весов модели. 2. МЕТОДЫ 2.1. Транзакционные Данные Оценки кредитного риска прогнозируются с использованием табличных данных по операциям с кредитными картами, где каждая транзакция связана с набором числовых и категориальных переменных. Мы определяем прогнозирование кредитного риска как задачу бинарной классификации, целью которой является выявление дефолта (неплатежа) по кредитной карте в течение 1,5 лет после даты обязательного платежа. 2.1.1. Особенности. Для наших модельных экспериментов мы использовали транзакционные данные по владельцам карт с потребительским кредитом. Источники данных включали как внутренние, так и внешние источники, такие, как агентства анализа (аудита) потребительских кредитов, из которых было создано 127 не идентифицированных параметрических функций. Наши функции можно разделить на две подкатегории: связанные с транзакциями (кредитный риск, индикатор банкомата и т. д.) и связанные со счетом (просроченные дни, срок владения счетом и т. д.). Чтобы обеспечить объективность, личная демографическая информация не была включена ни в одну из функций. Однако из-за соображений конфиденциальности и строгого соблюдения законов о защите данных мы не можем описать наши функции более подробно. 2.1.2. Обучение и проверка. Набор обучающих данных состоял из выборки по 15 миллионам участников карт с транзакциями, охватывающими курс в течение двенадцати месяцев с марта 2016 года по февраль 2017 года. Мы дважды сдвинули окно годового прогноза вперед на один месяц, чтобы создать 45 миллионов транзакционных последовательностей для обучения. Это означает, что каждый элемент карты трижды появлялся в наборе обучающих данных с немного разными (сдвинутыми во времени) данными последовательности. Набор данных для валидации состоял из выборки по 6 миллионам неперекрывающихся (вне выборки) владельцев карт, причем транзакции охватывали двенадцать месяцев с мая 2017 года по апрель 2018 года, чтобы также создать набор валидации вне рассматриваемого времени. Это имитирует среду, где модели обучаются на прошлых данных. В рамках этих выборочных наборов данных примерно 2% участников карт не выполнили свои обязательства по кредитному балансу. Мы рассмотрели этот дисбаланс классов в контексте глубокого обучения, создав сбалансированные мини-пакеты для обучающих моделей с мини-пакетным градиентным спуском, где каждый мини-пакет имел тот же процент членов карты по умолчанию, что и весь набор данных.2.1.3. Предварительная обработка. Нейронные сети чувствительны к распределениям признаков, и производительность может значительно снизиться для распределений, не подчиняющихся нормальному закону. Наши табличные наборы данных содержат много объектов с похожим поведением, и поэтому стандартные подходы к предварительной обработке объектов не приведут к лучшим результатам. Поэтому наша предварительная обработка состояла в следующем:

- пропущенные значения для каждой функции были заполнены на основе целевых меток (по умолчанию/не по умолчанию) в пределах 10 ячеек, определенных процентилями функции;

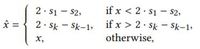

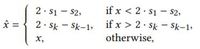

- для работы с «выбивающимися» из выборки данными мы разработали новую процедуру их отсеивания, чтобы извлечь наиболее значительную часть распределения признаков, используя разбиения, полученные в результате обучения модели дерева решений (в нашем случае использовалась структура GBDT), для каждого объекта и всех деревьев, созданных моделью, мы отсортировали все разбиения в порядке возрастания: (s1, s2, . . . , sk ), si > sj , for all i > j, и применили следующие правила ограничения:

где x - исходный объект, а xˆ- преобразованный объект (иллюстративный пример см. на рис. 1); • после отбраковки было применено преобразование Бокса-Кокса для уменьшения асимметрии признаков [5]; • количественные (категориальные) данные были преобразованы в числовые характеристики с помощью процедуры, известной как сглаживание Лапласа [18] и которая содержит два основных шага:

- вычисление среднего значения целевой переменной в каждой категории;

- изменение среднего значения с шага 1, чтобы обратиться к категориям с небольшим количеством наблюдений:

где G - набор индексов для данной категории, | G | - размер категории, k – мета-параметр, определенный эмпирически (в нашем случае k = 30), и y - среднее значение целевой переменной для всех обучающих наблюдений. • наконец, ко всем объектам было применено стандартное масштабирование.

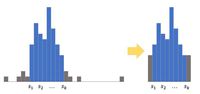

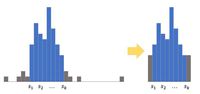

Рисунок 1: Уплотнение с помощью разбиения GBDT. 2.2. Операции выборки для генерации последовательностей Генерирование последовательностей операций по кредитным картам в течение фиксированного периода времени представляет собой уникальный подход для оценки риска. В течение определенного периода времени участники карт могут совершать различные по виду и объемами сумм транзакции. Например, в течение одного года у одного с помощью карты может быть совершено только несколько транзакций, а у другого - тысячи. Поэтому вместо того, чтобы моделировать полные последовательности транзакций в течение года, мы создали схему выборки, которая выбирает одну случайную транзакцию с отслеживаемой историей на одного участника карты в месяц. Преимущество этого метода отбора проб – двоякое. Во-первых, он уменьшает шум, чтобы выявить более общие тенденции в риск-поведении в течение длительного периода времени. Во-вторых, это позволяет создавать и обрабатывать последовательности почти в реальном времени, потому что предыдущие 11 месяцев транзакций могут быть эффективно сохранены в памяти и быстро загружены. Мы просто добавляем каждую входящую транзакцию в текущий месяц до конца последовательности перед отправкой ее в последовательность моделей (иллюстрация приведена на рис. 2). Это важно для реализации последовательности моделей в нашей операционной среде, где требуется скорость обработки почти как в реальном времени для расчета оценки кредитного риска по каждой входящей транзакции до ее утверждения (обычно менее 10 миллисекунд).

Рисунок 2: Последовательность выбранных транзакций.Для неактивных участников карты с нулевыми транзакциями в данном месяце данные были собраны по ежемесячным выпискам из счетов. Причина, по которой мы используем случайные истории транзакции вместо даты выписки по счету для активных участников карты – в том, что мы хотим спрогнозировать кредитный риск для каждой входящей транзакции, которая не происходит в фиксированный интервал времени. Поэтому мы вводим шум во временной интервал, чтобы уменьшить зависимость модели от него. Для участников с небольшими сроками владения и доступностью транзакций менее 12 месяцев, мы добавили в последовательности нулевые значения и применили двоичную маску к расчетам потерь во время обучения. Этот метод исключает использование заполненных временных меток для обновления весов модели. 2.3. Эволюционная модель Мы сравнили четыре различных типа классификационных моделей глубокого обучения, от простых нейронных сетей до более сложных, сравнили их производительность с эталонной моделью GBDT для прогнозирования кредитного риска. Поскольку алгоритм GBDT не был разработан для размещения последовательных данных, мы использовали только самую последнюю транзакцию месяца для обучения модели. Точно так же, две модели глубокого обучения (многослойный персептрон и TabNet) не являются последовательными и используются только в последней транзакции месяца. 2.3.1 Многослойный персептрон. Мы начали наши эксперименты по глубокому обучению с простой реализации стандартной многослойной нейронной сети ванильного персептрона (MLP) с регуляризацией отсева. MLP соединяет несколько слоев узлов/нейронов в связном графе. Регуляризация отсева стохастически "сбрасывает" некоторые из этих нейронов во время обучения, чтобы смоделировать ансамбль различных MLP [13]. Для обучения весов связей модели было использовано обобщение алгоритма наименьших среднеквадратичных отклонений, известного как обратное распространение, для вычисления градиента функции потерь по отношению к каждому весу по цепному правилу, итеративному назад от последнего слоя. 2.3.2. TabNet. TabNet - это нейронная сеть, недавно разработанная специально для табличных непоследовательных данных [2]. Она использует механизм итеративного внимания для выбора функций, где окончательная оценка прогноза представляет собой совокупность всей обработанной информации на предыдущих итерациях. Одна итерация архитектуры TabNet состоит из двух частей: преобразователя функций и преобразователя внимательного отношения. Выходные данные преобразователя признаков объединяются с выходными данными предыдущих итераций, чтобы получить окончательное решение о выходе. Преобразователь внимания создает разреженный вектор маски признаков, который применяется обратно к начальному набору признаков, чтобы выделить меньшее подмножество признаков, которое передается на следующий шаг принятия решения (см. Рисунок 3). Преимущество этого метода заключается в том, что он позволяет сети в полной мере использовать наиболее важные функции в табличном наборе данных на каждом этапе принятия решения, что обеспечивает более эффективное обучение.

Рисунок 3: Архитектура шагов принятия решений TabNet.2.3.3. Рекуррентная нейронная сеть. Вышеупомянутые модели глубокого обучения страдают от того же ограничения, что и базовая модель GBDT: они явно не используют исторические данные членов карты. RNNS решает эту проблему путем итеративной обработки и сохранения информации из предыдущих транзакций в своих скрытых узлах, которая затем добавляется к текущей транзакции для получения более обоснованного прогноза кредитного риска. Для этой работы мы использовали long short-term memory (LSTM) RNN [14], который является популярным вариантом ванильного RNN. Как было показано, он более эффективно изучает долгосрочные зависимости в последовательных данных. Мы также использовали более новый метод регуляризации RNN, известный как регуляризация zoneout [17]. Как и регуляризация отсева, zoneout использует случайный шум для аппроксимации обучения ансамбля различных RNN. Однако вместо того, чтобы отбрасывать случайные рекуррентные веса соединений, zoneout стохастически заставляет некоторые скрытые узлы сохранять свои предыдущие значения из предыдущей транзакции. Преимущество использования zoneout по сравнению с рекуррентным отсевом заключается в том, что он позволяет RNN запоминать больше информации из прошлых транзакций. Пример однослойной модели LSTM с регуляризацией zoneout для прогнозирования оценок кредитного риска с использованием нашего подхода предварительной обработки показан на рис.4.

Рисунок 4: Однослойная архитектура LSTM для прогнозирования кредитного риска (т. е. дефолта по долгам кредитных карт) на основе 12-месячных транзакционных данных. 2.3.4 Временная сверточная сеть. Важным ограничением структуры RNN является то, что обучение модели может быть трудоемким, поскольку последовательности данных обрабатываются итеративно. Кроме того, способность RNN фиксировать долгосрочные зависимости в последовательностях остается фундаментальной проблемой [21]. Поэтому более поздние методы сосредоточились на более эффективных подходах, основанных на свертке последовательных данных [4, 7, 11, 15, 20]. Поскольку свертки могут выполняться параллельно, последовательности обрабатываются как единое целое, а не итеративно, как в RNNs. Сверточные нейроны также могут использовать свое рецептивное поле, чтобы сохранить еще больше информации из далекого прошлого. Причинные свертки предотвращают утечку из будущего, только свертывая выход в момент времени t с элементами из времени t и ранее (см. рис. 5) [25]. Возможно, самым популярным в последнее время подходом, основанным на причинной свертке, является временная сверточная сеть (TCN) [4]. В дополнение к свертке и отсеву, TCNS используют дилатацию (регулирование), чтобы обеспечить большие размеры рецептивного поля, которые оглядываются назад на более длинные длины истории, вводя фиксированный размер шага между каждыми двумя соседними отводами сверточного фильтра [27]. TCNS также используют остаточные связи, так что каждый сверточный слой изучает отображение идентичности, а не все преобразование (см. рис. 6), что помогает стабилизировать более глубокие и широкие модели [12]. Внутри каждого остаточного блока TCN нормализация слоя применяется к выходу сверточного слоя, а отсев добавляется для регуляризации. Иллюстрация нашей окончательной архитектуры deep TCN для задачи прогнозирования кредитного риска показана на рис. 7.

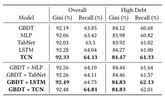

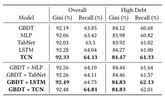

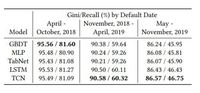

Рисунок 6: Блок TCN. 2.4. Оптимизация и настройка модели 2.4.1. Архитектура. Конечное количество слоев, нейронов на слой и коэффициенты отсева/зональности, используемые в каждой модели глубокого обучения, были определены с использованием итеративного байесовского оптимизационного подхода с помощью SigOpt [8]. Тем не менее, некоторые из топ-моделей действовали аналогично. Мы обнаружили, что наилучшая производительность наблюдается для 5-слойного MLP, 3-слойного LSTM (с 2 слоями LSTM и одним плотным выходным слоем) и 6-слойного TCN (с 2 блоками TCN и 4 плотными слоями). Показатели отсева и зонального отсева в каждой модели оставались довольно низкими (в среднем ~0,2). 2.4.2. Оптимизация. Каждая модель глубокого обучения была обучена с использованием алгоритма оптимизации Адама [16] и ранней остановки [22]. Мы использовали бета-параметры по умолчанию для алгоритма Адама (бета = 0,9, 0,999), которые управляют скоростью затухания для оценок градиента первого и второго моментов, хотя другие значения были исследованы и не показали очевидного улучшения. Классическая бинарная функция кросс-энтропии для задач классификации использовалась в качестве функции потерь, подлежащей оптимизации. 2.4.3. Размер партии и скорость обучения. Мы также экспериментировали с несколькими размерами пакетов, скоростью обучения и графиками скорости обучения для различных архитектур. Мы обнаружили, что универсальный размер пакета из 512 членов кредитной карты и скорость распада 0,8, начиная с начальной скорости обучения 1e-4, как правило, является наиболее эффективным для всех моделей. 2.4.4 Показатели эффективности. Производительность измерялась с помощью коэффициента Джини и отзыва. Коэффициент Джини является общим измерителем дискриминационной силы рейтинговых систем, таких как модели кредитного скоринга. Он прямо пропорционален площади под характеристической кривой оператора приемника (Джини = (2*AUROC) - 1). Отзыв, или чувствительность, - это измерение правильных прогнозов дефолта кредитной карты в пределах фиксированной доли лучших прогнозных оценок модели. Эта доля определялась существующими бизнес-принципами и фиксировалась в разных моделях. 3. РЕЗУЛЬТАТЫ Результаты работы для каждой отдельной модели глубокого обучения и ее ансамбля с эталонным GBDT приведены в таблице 1. Результаты деятельности для субпопуляции с высоким уровнем долговой нагрузки (владельцы карт с балансом более 15 000 долларов США) также включены в эту таблицу, чтобы продемонстрировать потенциал существенной финансовой экономии с использованием предложенного нами подхода.

Таблица 1: Эффективность индивидуальной и ансамблевой моделей для населения в целом и населения с высоким уровнем задолженности (более 15 тыс. долл.) Последовательные модели, LSTM и TCN, по отдельности превзошли тестовый GBDT. Непоследовательные нейронные сети MLP и TabNet показали худшие результаты по сравнению с тестом. Кроме того, гораздо больший рост производительности прогнозирования наблюдался, когда LSTM и TCN использовались в ансамбле с GBDT, предполагая, что историческая информация предоставляет ортогональную информацию, которая позволяет прогнозировать рискованное финансовое поведение. Хотя эти улучшения производительности могут показаться скромными, важно помнить о большом количестве владельцев карт, которые существуют в наборе данных, а это означает, что небольшие улучшения приводят к значительной экономии (в нашем случае годовая экономия в десятки миллионов долларов США ).

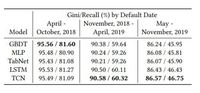

Таблица 2: Производительность отдельных моделей, разделенная по дате по умолчанию.3.1. Раннее выявление рисков. Помимо выявления более рискованных типов поведения, еще одной важной задачей модели было выявление рискованного поведения как можно раньше, до наступления дефолта по кредиту. Это очень важно, когда превентивные меры должны быть приняты за несколько месяцев вперед, чтобы уменьшить будущие финансовые потери. Сравнение LSTM и TCN с GBDT для трех различных временных интервалов (с событием, по умолчанию происходящим в краткосрочной, среднесрочной и долгосрочной перспективе) показано в таблице 2. В то время, как GBDT, по-видимому, превосходит последовательную модель в прогнозировании дефолтов в ближайшей перспективе (в течение 6 месяцев после самой последней транзакции), кредитная информация, включенная в последовательную модель, помогает более эффективно прогнозировать дефолты в среднесрочной перспективе (между 7-12 месяцами после самой последней транзакции) и долгосрочной перспективе (между 13-18 месяцами после самой последней транзакции), что указывает на то, что наш подход улучшает раннее обнаружение рисков. 3.2. Длина последовательности. Производительность последовательных моделей также зависела от количества используемых входных транзакций (то есть от длины последовательности). На рисунке 8 мы демонстрируем снижение производительности с точки зрения индекса Джини и напоминаем, что количество ежемесячных исторических транзакций, включенных в последовательности, уменьшилось, что означает, что период «ретроспективного анализа» был короче, чем полный год. И LSTM, и TCN достигли лучших результатов за 12 месяцев транзакций, при этом TCN превзошел LSTM на каждой длине последовательности. Учитывая линейное увеличение производительности от длины последовательности, это говорит о том, что более глубокий анализ кредитной истории заемщиков может обеспечить более высокие результаты. Однако мы были ограничены доступными данными, не предшествующими 2016 г.

Рисунок 8: Производительность увеличивается по мере увеличения количества ежемесячных транзакций в последовательности. 3.3. Онлайн-обучение. Поскольку известно, что производительность модели ухудшается с изменением потребительского поведения и экономических условий, мы также проверили способность LSTM и TCN адаптироваться к поступающим данным с помощью онлайн-обучения. Для этого мы постепенно настраивали веса каждой модели, используя последовательности, собранные за три будущих месяца 2017 года. Мы сравнили этот метод со стандартным методом случайной инициализации веса на рис. 9, где веса модели задаются небольшими случайными числами перед обучением. Как и ожидалось, производительность постепенно улучшалась по мере того, как для создания прогнозов использовались более свежие данные. Кроме того, постепенная настройка весов с входящими данными превзошла стандартный подход инициализации случайных весов.

Рисунок 9: Онлайн-обучение (т. е. постепенная настройка весов с использованием входящих данных) дало более высокие результаты производительности по сравнению с повторной инициализацией весов с небольшими случайными значениями перед обучением. 3.4. Время обучения и вывода. Хотя TCN превзошел LSTM с точки зрения производительности прогнозирования, важно также учитывать их производительность с точки зрения обучения и времени вывода для использования в операционной среде. Используя графический процессор NVDIA Tesla V100, потребовалось в среднем ~30 мс, чтобы обучить TCN на одной мини-партии из 512 членов карты, по сравнению с ~50 мс для LSTM. Это было ожидаемо, поскольку входная последовательность обрабатывается TCN в целом, а не последовательно, как в LSTM. Как ни странно, время вывода для LSTM должно быть быстрее, чем для TCN. Как было предложено Bai et al. [4], LSTM нужно только сохранить предпоследнее скрытое состояние в памяти и принять текущие/входящие транзакционные данные, чтобы сгенерировать прогноз. В отличие от этого, TCN должен обработать всю последовательность. Однако оба метода смогли обработать последовательность менее, чем за 1 мс, что намного меньше времени, необходимого для вывода в нашей производственной среде (менее 10 мс). В будущей работе мы проанализируем полный конвейер для вывода, который включает в себя время, необходимое для предварительной обработки данных для входящей транзакции, а также время, необходимое для загрузки исторических данных (TCN) и предпоследнего скрытого состояния (LSTM). 4. ВЫВОДЫ. Современные модели мониторинга кредитного риска, как правило, используют усиленные деревья принятия решений для их более высокой точности обобщения по сравнению с другими популярными методами, такими как многослойный персептрон. Однако этот подход ограничен своими входными возможностями и неспособностью эффективно обрабатывать последовательные данные. В этой статье мы исследовали последовательные методы глубокого обучения для скоринга кредитного риска и предложили новый метод выборки для генерации последовательностей из одного года табличных финансовых данных, связанных с транзакциями. Мы сравнили эффективность нашего подхода с текущей моделью производства на основе дерева и показали, что наша TCN в сочетании с нашей методикой выборки достигла превосходных результатов с точки зрения финансовой экономии и раннего выявления рисков дефолта. Наконец, мы представили доказательства того, что эта структура будет пригодна в нашей операционной среде и для онлайн-обучения. Одной из основных проблем нашего подхода является отсутствие интерпретируемости, которая поражает модели черного ящика, такие как предлагаемые LSTM и TCN. Однако, поскольку GBDT также страдает от аналогичной проблемы интерпретируемости, мы не используем напрямую прогнозные оценки модели для принятия решений на уровне расчетов. Вместо этого, установленные и стратегические бизнес-правила используются поверх (и параллельно) прогнозной оценки для обеспечения справедливости и удовлетворенности клиентов. Будущая работа будет сосредоточена на стресс-тестировании наших глубоких последовательных моделей и зондировании результатов прогнозирования, чтобы определить, существуют ли субпопуляции владельцев карт, для которых наш новый подход работает лучше, чем эталонный. Важно также отметить, что наши данные были собраны в относительно стабильный экономический период, который не включал в себя никаких серьезных рецессий. По мере того как будут собираться все больше данных, мы сможем проверить устойчивость и способность к обобщению нашего подхода. Ссылки[1] Peter Martey Addo, Dominique Guegan, and Bertrand Hassani. 2018. Credit

risk analysis using machine and deep learning models. Risks 6, 2 (2018), 38.

https://doi.org/10.3390/risks6020038

[2] Sercan O. Arik and Tomas Pfister. 2019. TabNet: Attentive Interpretable Tabular

Learning. (2019). arXiv:1908.07442

[3] Dmitrii Babaev, Alexander Tuzhilin, Maxim Savchenko, and Dmitrii Umerenkov. E.T.-Rnn: Applying deep learning to credit loan applications. In Proceedings of the ACM SIGKDD International Conference on Knowledge Discovery and Data Mining. 2183–2190. https://doi.org/10.1145/3292500.3330693[4] Shaojie Bai, J. Zico Kolter, and Vladlen Koltun. 2018. An Empirical Evaluation of Generic Convolutional and Recurrent Networks for Sequence Modeling. (2018). arXiv:1803.01271 [5] George EP Box and David R Cox. 1964. An analysis of transformations. Journal of the Royal Statistical Society: Series B (Methodological) 26, 2 (1964), 211–243. [6] Tianqi Chen and Carlos Guestrin. 2016. Xgboost: A scalable tree boosting system. In Proceedings of the 22nd ACM SIGKDD Unternational Conference on Knowledge Discovery and Data Mining. 785–794. [7] Yann N Dauphin, Angela Fan, Michael Auli, and David Grangier. 2017. Language modeling with gated convolutional networks. In Proceedings of the 34th International Conference on Machine Learning. 933–941. [8] Ian Dewancker, Michael McCourt, and Scott Clark. 2015. Bayesian Optimization Primer. [9] Dmitry Efimov, Di Xu, Alexey Nefedov, and Archana Anandakrishnan. 2019. Using Generative Adversarial Networks to Synthesize Artificial Financial Datasets. In 33rd Conference on Neural Information Processing Systems, Workshop on Robust AI in Financial Services. [10] Jerome H. Friedman. 2001. Greedy function approximation: A gradient boosting machine. Annals of Statistics 29, 5 (2001), 1189–1232. https://doi.org/10.2307/ 2699986 [11] Jonas Gehring, Michael Auli, David Grangier, Denis Yarats, and Yann N Dauphin. Convolutional sequence to sequence learning. In Proceedings of the 34th International Conference on Machine Learning. 1243–1252. [12] Kaiming He, Xiangyu Zhang, Shaoqing Ren, and Jian Sun. 2016. Identity mappings in deep residual networks, Vol. 9908 LNCS. Springer Verlag, 630–645. https://doi.org/10.1007/978-3-319-46493-0_38 arXiv:1603.05027[13] Geoffrey E Hinton, Nitish Srivastava, Alex Krizhevsky, Ilya Sutskever, and Ruslan R Salakhutdinov. 2012. Improving neural networks by preventing coadaptation of feature detectors. arXiv:1207.0580 (2012). [14] Sepp Hochreiter and Jürgen Schmidhuber. 1997. Long Short-Term Memory. Neural Computation 9, 8 (1997), 1735–1780. https://doi.org/10.1162/neco.1997.9. 8.1735 [15] Nal Kalchbrenner, Lasse Espeholt, Karen Simonyan, Aaron van den Oord, Alex Graves, and Koray Kavukcuoglu. 2016. Neural machine translation in linear time. arXiv preprint arXiv:1610.10099 (2016). [16] Diederik P Kingma and Jimmy Ba. 2014. Adam: A method for stochastic optimization. arXiv preprint arXiv:1412.6980 (2014). [17] David Krueger, Tegan Maharaj, János Kramár, Mohammad Pezeshki, Nicolas Ballas, Nan Rosemary Ke, Anirudh Goyal, Yoshua Bengio, Aaron Courville, and Chris Pal. 2017. Zoneout: Regularizing rnns by randomly preserving hidden activations. In Proceedings of the 5th International Conference on Learning Representations. arXiv:1606.01305 [18] Christopher D Manning, Prabhakar Raghavan, and Hinrich Schütze. 2008. Introduction to information retrieval. Cambridge University Press. 234–265 pages. [19] Loris Nanni and Alessandra Lumini. 2009. An experimental comparison of ensemble of classifiers for bankruptcy prediction and credit scoring. Expert Systems with Applications 36, 2 (2009), 3028–3033. https://doi.org/10.1016/j.eswa. 2008.01.018 [20] Aaron van den Oord, Sander Dieleman, Heiga Zen, Karen Simonyan, Oriol Vinyals, Alex Graves, Nal Kalchbrenner, Andrew Senior, and Koray Kavukcuoglu. Wavenet: A generative model for raw audio. arXiv preprint arXiv:1609.03499 (2016). [21] Razvan Pascanu, Tomas Mikolov, and Yoshua Bengio. 2013. On the difficulty of training recurrent neural networks. In Proceedings of the 30th International Conference on Machine Learning. 1310–1318. [22] Lutz Prechelt. 1998. Early stopping-but when? In Neural Networks: Tricks of the trade. Springer, 55–69. [23] Abhimanyu Roy, Jingyi Sun, Robert Mahoney, Loreto Alonzi, Stephen Adams, and Peter Beling. 2018. Deep learning detecting fraud in credit card transactions. In Proceedings of the Systems and Information Engineering Design Symposium,129–134. https://doi.org/10.1109/SIEDS.2018.8374722 [24] Lyn C Thomas, David B Edelman, and Jonathan N Crook. 2002. Credit scoring and its applications. SIAM. [25] Alex Waibel, Toshiyuki Hanazawa, Geoffrey Hinton, Kiyohiro Shikano, and Kevin J Lang. 1989. Phoneme recognition using time-delay neural networks. IEEE transactions on acoustics, speech, and signal processing 37, 3 (1989), 328–339. [26] Chongren Wang, Dongmei Han, Qigang Liu, and Suyuan Luo. 2018. A deep learning approach for credit scoring of Peer-to-Peer lending using attention mechanism LSTM. IEEE Access 7 (2018), 2161–2168. [27] Fisher Yu and Vladlen Koltun. 2016. Multi-scale context aggregation by dilated convolutions. In Proceedings of the 4th International Conference on Learning Representations. arXiv:1511.07122

===========

Источник:

habr.com

===========

===========

Автор оригинала: Jillian M. Clements, Di Xu, Nooshin Yousef, Dmitry Efimov

===========Похожие новости:

- [Машинное обучение, Учебный процесс в IT, Конференции] Что там в Университете ИТМО: дайджест мероприятий для студентов, ученых и специалистов разного уровня

- [Машинное обучение, Искусственный интеллект] Инструменты для участников соревнований по машинному обучению

- [Машинное обучение, Научно-популярное, Искусственный интеллект] Исследователи обучили ИИ познавать мир путем поиска спрятанных вещей

- [Обработка изображений, Машинное обучение, Искусственный интеллект, Медгаджеты, Мозг] Модель машинного обучения восстановила изображения, которые видел человек

- [Python, Big Data, Машинное обучение, Natural Language Processing] Как с помощью нейросети определить лучшую дату отправки email и повысить доход рассылки в 8,5 раз

- [Python, Машинное обучение, Искусственный интеллект] Генерация текста с помощью GPT2 и PyTorch (перевод)

- [Машинное обучение, Искусственный интеллект] Исследователи создали систему на ИИ, которая тренирует собак

- [Python, Программирование, Машинное обучение] Ранжирование текстов по похожести на опорные тексты при помощи модели TF-IDF в реализации GENSM

- [Машинное обучение, IT-компании] Как датасеты аккумулируют в себе расизм и сексизм (перевод)

- [Алгоритмы, Машинное обучение, Исследования и прогнозы в IT, Искусственный интеллект] Исследователи изучают, как GPT-3 разбирает входящую почту

Теги для поиска: #_mashinnoe_obuchenie (Машинное обучение), #_neural, #_tabular, #_credit_risk, #_recurrent_neural_network, #_mashinnoe_obuchenie (

Машинное обучение

)

Вы не можете начинать темы

Вы не можете отвечать на сообщения

Вы не можете редактировать свои сообщения

Вы не можете удалять свои сообщения

Вы не можете голосовать в опросах

Вы не можете прикреплять файлы к сообщениям

Вы не можете скачивать файлы

Текущее время: 15-Янв 13:12

Часовой пояс: UTC + 5

| Автор | Сообщение |

|---|---|

|

news_bot ®

Стаж: 7 лет 11 месяцев |

|

|

Аннотация Машинное обучение играет важную роль в предотвращении финансовых потерь в банковской отрасли. Возможно, наиболее актуальной задачей прогнозирования, является оценка кредитного риска (риска дефолта по долгу). Такие риски могут привести к потерям в миллиарды долларов ежегодно. Сегодня большая часть выгод от машинного обучения в проблеме прогнозирования кредитного риска обусловлена моделями дерева решений с градиентным усилением. Тем не менее, эти выгоды начинают снижаться, если не поддерживаются новыми источниками данных и/или высокотехнологичных, гибких функций. В этой статье мы представляем наши попытки создать новый подход оценки кредитного риска с использованием глубокого обучения, который не предполагает сложного мониторинга, не опирается на новые входные данные модели. Мы предлагаем новые методы выборки транзакций по кредитным картам для использования с глубокими рекуррентными и причинно-следственными сверточными нейронными сетями, которые используют временные последовательности финансовых данных, без особых требований к ресурсам. Показываем, что наш последовательный подход к глубокому обучению с использованием временной сверточной сети превзошел эталонную непоследовательную древовидную модель, добившись значительной финансовой экономии и раннего обнаружения кредитного риска. Мы также демонстрируем потенциал нашего подхода для его использования в производственной среде, где предлагаемая методика выборки позволяет эффективно хранить последовательности в памяти, используя их для быстрого онлайн-обучения и продукций. KEYWORDS credit risk, tabular data, credit card transactions, recurrent neural networks, temporal convolutional networks 1. ВВЕДЕНИЕ Когда заемщики банка попадают в кризисную ситуацию, раннее обнаружение даже небольших изменений, уязвимостей в их финансовом положении может существенно уменьшить убытки банка, если своевременно принять превентивные меры (например, снижение кредитного лимита заемщика). Фактически, непрерывный мониторинг кредитного риска является неотъемлемой частью большинства стратегий снижения убытков в банковской отрасли [24]. Современные модели кредитного скоринга для оценки риска обычно опираются на деревья решений с градиентным усилением (GBDTs), которые обеспечивают ряд преимуществ по сравнению с традиционными методами, такими как логистическая регрессия [10]. Например, взаимодействия между переменными автоматически генерируются в процессе усиления связей и комбинируются для повышения точности прогнозирования. Кроме этого, этапы предварительной обработки, такие как заполнение пропущенных значений и отбраковка данных, как правило, не требуются. Однако эти модели также имеют определенные ограничения. Во-первых, повышение производительности обычно достигается за счет разработки функций для ввода новых переменных, основанных на обширных знаниях и опыте предметной области. Во-вторых, древовидные модели неполно используют предысторию в данных. Наконец, они не могут быть использованы в режиме онлайн-обучения (где данные становятся доступны последовательно) из-за их ограниченных возможностей по обновлению, таким как изменение разбиений, без просмотра всего набора данных с самого начала (например, [6]). Чтобы преодолеть ограничения традиционного древовидного подхода, мы исследовали несколько методов глубокого обучения для оценки кредитного риска и создали уникальный метод генерации последовательностей операций по кредитным картам, который изучает годовую кредитную историю заемщиков. Применяя те же входные характеристики, что и эталонная модель GBDT, мы показываем, что наш последовательный подход к глубокому обучению с использованием временной сверточной сети (TCN) обеспечивает явные преимущества по сравнению с древовидной методикой. Основное улучшение заключается в том, что производительность существенно возрастает, что приводит к значительной финансовой экономии и более раннему выявлению кредитного риска. Мы также демонстрируем потенциал использования нашего подхода в онлайн-обучении для мониторинга кредитного риска без внесения существенных изменений в учебный процесс. Предыдущие исследования применения глубокого обучения к табличным данным по транзакциям с помощью кредитных карт были направлены на обнаружение мошенничества [9, 23], заявки на получение кредита [3, 26] и мониторинг кредитных рисков [1,19]. Наша работа отличается от предыдущей работы по глубокому обучению мониторингу кредитного риска тем, что она выходит за рамки простых многослойных сетей персептронов и включает последовательные методы, такие как рекуррентные нейронные сети (RNN) и TCN, которые явно используют доступные данные предыстории. Кроме того, мы представляем новый метод выборки для создания последовательностей транзакций, который устраняет резкие различия в длине кредитной истории участников в течение всего года. Преимущества использования выборочных транзакций из длительного временного горизонта, в отличие от общего количества транзакций, заключаются в том, что это уменьшает «белый шум» в данных, требования к памяти и времени обучения/логического вывода. Следовательно, модель может изучать, обобщать ранние предупреждающие признаки финансовых риск-операций. При этом сохраняется возможность работать почти в реальном времени во время онлайн-мониторинга кредита. Основные результаты, представленные в этой статье, заключаются в следующем. Сначала мы показываем потенциал последовательного глубокого обучения для улучшения нашей текущей системы кредитного скоринга с помощью автономного анализа, который выявил значительное сокращение финансовых потерь (десятки миллионов долларов США ежегодно) и возможности повышения скорости раннего выявления риск-ситуаций. Мы также разработали метод выборки для генерации последовательностей транзакций в течение целого года, который позволяет модели изучать долгосрочные поведенческие тенденции и устраняет необходимость загружать и обрабатывать сотни миллиардов транзакций по кредитным картам заемщиков ежегодно. Наконец, мы демонстрируем, что онлайн-обучение может быть применено к нашему подходу и обеспечивает более высокую производительность по сравнению со случайной повторной инициализацией весов модели. 2. МЕТОДЫ 2.1. Транзакционные Данные Оценки кредитного риска прогнозируются с использованием табличных данных по операциям с кредитными картами, где каждая транзакция связана с набором числовых и категориальных переменных. Мы определяем прогнозирование кредитного риска как задачу бинарной классификации, целью которой является выявление дефолта (неплатежа) по кредитной карте в течение 1,5 лет после даты обязательного платежа. 2.1.1. Особенности. Для наших модельных экспериментов мы использовали транзакционные данные по владельцам карт с потребительским кредитом. Источники данных включали как внутренние, так и внешние источники, такие, как агентства анализа (аудита) потребительских кредитов, из которых было создано 127 не идентифицированных параметрических функций. Наши функции можно разделить на две подкатегории: связанные с транзакциями (кредитный риск, индикатор банкомата и т. д.) и связанные со счетом (просроченные дни, срок владения счетом и т. д.). Чтобы обеспечить объективность, личная демографическая информация не была включена ни в одну из функций. Однако из-за соображений конфиденциальности и строгого соблюдения законов о защите данных мы не можем описать наши функции более подробно. 2.1.2. Обучение и проверка. Набор обучающих данных состоял из выборки по 15 миллионам участников карт с транзакциями, охватывающими курс в течение двенадцати месяцев с марта 2016 года по февраль 2017 года. Мы дважды сдвинули окно годового прогноза вперед на один месяц, чтобы создать 45 миллионов транзакционных последовательностей для обучения. Это означает, что каждый элемент карты трижды появлялся в наборе обучающих данных с немного разными (сдвинутыми во времени) данными последовательности. Набор данных для валидации состоял из выборки по 6 миллионам неперекрывающихся (вне выборки) владельцев карт, причем транзакции охватывали двенадцать месяцев с мая 2017 года по апрель 2018 года, чтобы также создать набор валидации вне рассматриваемого времени. Это имитирует среду, где модели обучаются на прошлых данных. В рамках этих выборочных наборов данных примерно 2% участников карт не выполнили свои обязательства по кредитному балансу. Мы рассмотрели этот дисбаланс классов в контексте глубокого обучения, создав сбалансированные мини-пакеты для обучающих моделей с мини-пакетным градиентным спуском, где каждый мини-пакет имел тот же процент членов карты по умолчанию, что и весь набор данных.2.1.3. Предварительная обработка. Нейронные сети чувствительны к распределениям признаков, и производительность может значительно снизиться для распределений, не подчиняющихся нормальному закону. Наши табличные наборы данных содержат много объектов с похожим поведением, и поэтому стандартные подходы к предварительной обработке объектов не приведут к лучшим результатам. Поэтому наша предварительная обработка состояла в следующем:

где x - исходный объект, а xˆ- преобразованный объект (иллюстративный пример см. на рис. 1); • после отбраковки было применено преобразование Бокса-Кокса для уменьшения асимметрии признаков [5]; • количественные (категориальные) данные были преобразованы в числовые характеристики с помощью процедуры, известной как сглаживание Лапласа [18] и которая содержит два основных шага:

где G - набор индексов для данной категории, | G | - размер категории, k – мета-параметр, определенный эмпирически (в нашем случае k = 30), и y - среднее значение целевой переменной для всех обучающих наблюдений. • наконец, ко всем объектам было применено стандартное масштабирование.  Рисунок 1: Уплотнение с помощью разбиения GBDT. 2.2. Операции выборки для генерации последовательностей Генерирование последовательностей операций по кредитным картам в течение фиксированного периода времени представляет собой уникальный подход для оценки риска. В течение определенного периода времени участники карт могут совершать различные по виду и объемами сумм транзакции. Например, в течение одного года у одного с помощью карты может быть совершено только несколько транзакций, а у другого - тысячи. Поэтому вместо того, чтобы моделировать полные последовательности транзакций в течение года, мы создали схему выборки, которая выбирает одну случайную транзакцию с отслеживаемой историей на одного участника карты в месяц. Преимущество этого метода отбора проб – двоякое. Во-первых, он уменьшает шум, чтобы выявить более общие тенденции в риск-поведении в течение длительного периода времени. Во-вторых, это позволяет создавать и обрабатывать последовательности почти в реальном времени, потому что предыдущие 11 месяцев транзакций могут быть эффективно сохранены в памяти и быстро загружены. Мы просто добавляем каждую входящую транзакцию в текущий месяц до конца последовательности перед отправкой ее в последовательность моделей (иллюстрация приведена на рис. 2). Это важно для реализации последовательности моделей в нашей операционной среде, где требуется скорость обработки почти как в реальном времени для расчета оценки кредитного риска по каждой входящей транзакции до ее утверждения (обычно менее 10 миллисекунд).  Рисунок 2: Последовательность выбранных транзакций.Для неактивных участников карты с нулевыми транзакциями в данном месяце данные были собраны по ежемесячным выпискам из счетов. Причина, по которой мы используем случайные истории транзакции вместо даты выписки по счету для активных участников карты – в том, что мы хотим спрогнозировать кредитный риск для каждой входящей транзакции, которая не происходит в фиксированный интервал времени. Поэтому мы вводим шум во временной интервал, чтобы уменьшить зависимость модели от него. Для участников с небольшими сроками владения и доступностью транзакций менее 12 месяцев, мы добавили в последовательности нулевые значения и применили двоичную маску к расчетам потерь во время обучения. Этот метод исключает использование заполненных временных меток для обновления весов модели. 2.3. Эволюционная модель Мы сравнили четыре различных типа классификационных моделей глубокого обучения, от простых нейронных сетей до более сложных, сравнили их производительность с эталонной моделью GBDT для прогнозирования кредитного риска. Поскольку алгоритм GBDT не был разработан для размещения последовательных данных, мы использовали только самую последнюю транзакцию месяца для обучения модели. Точно так же, две модели глубокого обучения (многослойный персептрон и TabNet) не являются последовательными и используются только в последней транзакции месяца. 2.3.1 Многослойный персептрон. Мы начали наши эксперименты по глубокому обучению с простой реализации стандартной многослойной нейронной сети ванильного персептрона (MLP) с регуляризацией отсева. MLP соединяет несколько слоев узлов/нейронов в связном графе. Регуляризация отсева стохастически "сбрасывает" некоторые из этих нейронов во время обучения, чтобы смоделировать ансамбль различных MLP [13]. Для обучения весов связей модели было использовано обобщение алгоритма наименьших среднеквадратичных отклонений, известного как обратное распространение, для вычисления градиента функции потерь по отношению к каждому весу по цепному правилу, итеративному назад от последнего слоя. 2.3.2. TabNet. TabNet - это нейронная сеть, недавно разработанная специально для табличных непоследовательных данных [2]. Она использует механизм итеративного внимания для выбора функций, где окончательная оценка прогноза представляет собой совокупность всей обработанной информации на предыдущих итерациях. Одна итерация архитектуры TabNet состоит из двух частей: преобразователя функций и преобразователя внимательного отношения. Выходные данные преобразователя признаков объединяются с выходными данными предыдущих итераций, чтобы получить окончательное решение о выходе. Преобразователь внимания создает разреженный вектор маски признаков, который применяется обратно к начальному набору признаков, чтобы выделить меньшее подмножество признаков, которое передается на следующий шаг принятия решения (см. Рисунок 3). Преимущество этого метода заключается в том, что он позволяет сети в полной мере использовать наиболее важные функции в табличном наборе данных на каждом этапе принятия решения, что обеспечивает более эффективное обучение.  Рисунок 3: Архитектура шагов принятия решений TabNet.2.3.3. Рекуррентная нейронная сеть. Вышеупомянутые модели глубокого обучения страдают от того же ограничения, что и базовая модель GBDT: они явно не используют исторические данные членов карты. RNNS решает эту проблему путем итеративной обработки и сохранения информации из предыдущих транзакций в своих скрытых узлах, которая затем добавляется к текущей транзакции для получения более обоснованного прогноза кредитного риска. Для этой работы мы использовали long short-term memory (LSTM) RNN [14], который является популярным вариантом ванильного RNN. Как было показано, он более эффективно изучает долгосрочные зависимости в последовательных данных. Мы также использовали более новый метод регуляризации RNN, известный как регуляризация zoneout [17]. Как и регуляризация отсева, zoneout использует случайный шум для аппроксимации обучения ансамбля различных RNN. Однако вместо того, чтобы отбрасывать случайные рекуррентные веса соединений, zoneout стохастически заставляет некоторые скрытые узлы сохранять свои предыдущие значения из предыдущей транзакции. Преимущество использования zoneout по сравнению с рекуррентным отсевом заключается в том, что он позволяет RNN запоминать больше информации из прошлых транзакций. Пример однослойной модели LSTM с регуляризацией zoneout для прогнозирования оценок кредитного риска с использованием нашего подхода предварительной обработки показан на рис.4.  Рисунок 4: Однослойная архитектура LSTM для прогнозирования кредитного риска (т. е. дефолта по долгам кредитных карт) на основе 12-месячных транзакционных данных. 2.3.4 Временная сверточная сеть. Важным ограничением структуры RNN является то, что обучение модели может быть трудоемким, поскольку последовательности данных обрабатываются итеративно. Кроме того, способность RNN фиксировать долгосрочные зависимости в последовательностях остается фундаментальной проблемой [21]. Поэтому более поздние методы сосредоточились на более эффективных подходах, основанных на свертке последовательных данных [4, 7, 11, 15, 20]. Поскольку свертки могут выполняться параллельно, последовательности обрабатываются как единое целое, а не итеративно, как в RNNs. Сверточные нейроны также могут использовать свое рецептивное поле, чтобы сохранить еще больше информации из далекого прошлого. Причинные свертки предотвращают утечку из будущего, только свертывая выход в момент времени t с элементами из времени t и ранее (см. рис. 5) [25]. Возможно, самым популярным в последнее время подходом, основанным на причинной свертке, является временная сверточная сеть (TCN) [4]. В дополнение к свертке и отсеву, TCNS используют дилатацию (регулирование), чтобы обеспечить большие размеры рецептивного поля, которые оглядываются назад на более длинные длины истории, вводя фиксированный размер шага между каждыми двумя соседними отводами сверточного фильтра [27]. TCNS также используют остаточные связи, так что каждый сверточный слой изучает отображение идентичности, а не все преобразование (см. рис. 6), что помогает стабилизировать более глубокие и широкие модели [12]. Внутри каждого остаточного блока TCN нормализация слоя применяется к выходу сверточного слоя, а отсев добавляется для регуляризации. Иллюстрация нашей окончательной архитектуры deep TCN для задачи прогнозирования кредитного риска показана на рис. 7.  Рисунок 6: Блок TCN. 2.4. Оптимизация и настройка модели 2.4.1. Архитектура. Конечное количество слоев, нейронов на слой и коэффициенты отсева/зональности, используемые в каждой модели глубокого обучения, были определены с использованием итеративного байесовского оптимизационного подхода с помощью SigOpt [8]. Тем не менее, некоторые из топ-моделей действовали аналогично. Мы обнаружили, что наилучшая производительность наблюдается для 5-слойного MLP, 3-слойного LSTM (с 2 слоями LSTM и одним плотным выходным слоем) и 6-слойного TCN (с 2 блоками TCN и 4 плотными слоями). Показатели отсева и зонального отсева в каждой модели оставались довольно низкими (в среднем ~0,2). 2.4.2. Оптимизация. Каждая модель глубокого обучения была обучена с использованием алгоритма оптимизации Адама [16] и ранней остановки [22]. Мы использовали бета-параметры по умолчанию для алгоритма Адама (бета = 0,9, 0,999), которые управляют скоростью затухания для оценок градиента первого и второго моментов, хотя другие значения были исследованы и не показали очевидного улучшения. Классическая бинарная функция кросс-энтропии для задач классификации использовалась в качестве функции потерь, подлежащей оптимизации. 2.4.3. Размер партии и скорость обучения. Мы также экспериментировали с несколькими размерами пакетов, скоростью обучения и графиками скорости обучения для различных архитектур. Мы обнаружили, что универсальный размер пакета из 512 членов кредитной карты и скорость распада 0,8, начиная с начальной скорости обучения 1e-4, как правило, является наиболее эффективным для всех моделей. 2.4.4 Показатели эффективности. Производительность измерялась с помощью коэффициента Джини и отзыва. Коэффициент Джини является общим измерителем дискриминационной силы рейтинговых систем, таких как модели кредитного скоринга. Он прямо пропорционален площади под характеристической кривой оператора приемника (Джини = (2*AUROC) - 1). Отзыв, или чувствительность, - это измерение правильных прогнозов дефолта кредитной карты в пределах фиксированной доли лучших прогнозных оценок модели. Эта доля определялась существующими бизнес-принципами и фиксировалась в разных моделях. 3. РЕЗУЛЬТАТЫ Результаты работы для каждой отдельной модели глубокого обучения и ее ансамбля с эталонным GBDT приведены в таблице 1. Результаты деятельности для субпопуляции с высоким уровнем долговой нагрузки (владельцы карт с балансом более 15 000 долларов США) также включены в эту таблицу, чтобы продемонстрировать потенциал существенной финансовой экономии с использованием предложенного нами подхода.  Таблица 1: Эффективность индивидуальной и ансамблевой моделей для населения в целом и населения с высоким уровнем задолженности (более 15 тыс. долл.) Последовательные модели, LSTM и TCN, по отдельности превзошли тестовый GBDT. Непоследовательные нейронные сети MLP и TabNet показали худшие результаты по сравнению с тестом. Кроме того, гораздо больший рост производительности прогнозирования наблюдался, когда LSTM и TCN использовались в ансамбле с GBDT, предполагая, что историческая информация предоставляет ортогональную информацию, которая позволяет прогнозировать рискованное финансовое поведение. Хотя эти улучшения производительности могут показаться скромными, важно помнить о большом количестве владельцев карт, которые существуют в наборе данных, а это означает, что небольшие улучшения приводят к значительной экономии (в нашем случае годовая экономия в десятки миллионов долларов США ).  Таблица 2: Производительность отдельных моделей, разделенная по дате по умолчанию.3.1. Раннее выявление рисков. Помимо выявления более рискованных типов поведения, еще одной важной задачей модели было выявление рискованного поведения как можно раньше, до наступления дефолта по кредиту. Это очень важно, когда превентивные меры должны быть приняты за несколько месяцев вперед, чтобы уменьшить будущие финансовые потери. Сравнение LSTM и TCN с GBDT для трех различных временных интервалов (с событием, по умолчанию происходящим в краткосрочной, среднесрочной и долгосрочной перспективе) показано в таблице 2. В то время, как GBDT, по-видимому, превосходит последовательную модель в прогнозировании дефолтов в ближайшей перспективе (в течение 6 месяцев после самой последней транзакции), кредитная информация, включенная в последовательную модель, помогает более эффективно прогнозировать дефолты в среднесрочной перспективе (между 7-12 месяцами после самой последней транзакции) и долгосрочной перспективе (между 13-18 месяцами после самой последней транзакции), что указывает на то, что наш подход улучшает раннее обнаружение рисков. 3.2. Длина последовательности. Производительность последовательных моделей также зависела от количества используемых входных транзакций (то есть от длины последовательности). На рисунке 8 мы демонстрируем снижение производительности с точки зрения индекса Джини и напоминаем, что количество ежемесячных исторических транзакций, включенных в последовательности, уменьшилось, что означает, что период «ретроспективного анализа» был короче, чем полный год. И LSTM, и TCN достигли лучших результатов за 12 месяцев транзакций, при этом TCN превзошел LSTM на каждой длине последовательности. Учитывая линейное увеличение производительности от длины последовательности, это говорит о том, что более глубокий анализ кредитной истории заемщиков может обеспечить более высокие результаты. Однако мы были ограничены доступными данными, не предшествующими 2016 г.  Рисунок 8: Производительность увеличивается по мере увеличения количества ежемесячных транзакций в последовательности. 3.3. Онлайн-обучение. Поскольку известно, что производительность модели ухудшается с изменением потребительского поведения и экономических условий, мы также проверили способность LSTM и TCN адаптироваться к поступающим данным с помощью онлайн-обучения. Для этого мы постепенно настраивали веса каждой модели, используя последовательности, собранные за три будущих месяца 2017 года. Мы сравнили этот метод со стандартным методом случайной инициализации веса на рис. 9, где веса модели задаются небольшими случайными числами перед обучением. Как и ожидалось, производительность постепенно улучшалась по мере того, как для создания прогнозов использовались более свежие данные. Кроме того, постепенная настройка весов с входящими данными превзошла стандартный подход инициализации случайных весов.  Рисунок 9: Онлайн-обучение (т. е. постепенная настройка весов с использованием входящих данных) дало более высокие результаты производительности по сравнению с повторной инициализацией весов с небольшими случайными значениями перед обучением. 3.4. Время обучения и вывода. Хотя TCN превзошел LSTM с точки зрения производительности прогнозирования, важно также учитывать их производительность с точки зрения обучения и времени вывода для использования в операционной среде. Используя графический процессор NVDIA Tesla V100, потребовалось в среднем ~30 мс, чтобы обучить TCN на одной мини-партии из 512 членов карты, по сравнению с ~50 мс для LSTM. Это было ожидаемо, поскольку входная последовательность обрабатывается TCN в целом, а не последовательно, как в LSTM. Как ни странно, время вывода для LSTM должно быть быстрее, чем для TCN. Как было предложено Bai et al. [4], LSTM нужно только сохранить предпоследнее скрытое состояние в памяти и принять текущие/входящие транзакционные данные, чтобы сгенерировать прогноз. В отличие от этого, TCN должен обработать всю последовательность. Однако оба метода смогли обработать последовательность менее, чем за 1 мс, что намного меньше времени, необходимого для вывода в нашей производственной среде (менее 10 мс). В будущей работе мы проанализируем полный конвейер для вывода, который включает в себя время, необходимое для предварительной обработки данных для входящей транзакции, а также время, необходимое для загрузки исторических данных (TCN) и предпоследнего скрытого состояния (LSTM). 4. ВЫВОДЫ. Современные модели мониторинга кредитного риска, как правило, используют усиленные деревья принятия решений для их более высокой точности обобщения по сравнению с другими популярными методами, такими как многослойный персептрон. Однако этот подход ограничен своими входными возможностями и неспособностью эффективно обрабатывать последовательные данные. В этой статье мы исследовали последовательные методы глубокого обучения для скоринга кредитного риска и предложили новый метод выборки для генерации последовательностей из одного года табличных финансовых данных, связанных с транзакциями. Мы сравнили эффективность нашего подхода с текущей моделью производства на основе дерева и показали, что наша TCN в сочетании с нашей методикой выборки достигла превосходных результатов с точки зрения финансовой экономии и раннего выявления рисков дефолта. Наконец, мы представили доказательства того, что эта структура будет пригодна в нашей операционной среде и для онлайн-обучения. Одной из основных проблем нашего подхода является отсутствие интерпретируемости, которая поражает модели черного ящика, такие как предлагаемые LSTM и TCN. Однако, поскольку GBDT также страдает от аналогичной проблемы интерпретируемости, мы не используем напрямую прогнозные оценки модели для принятия решений на уровне расчетов. Вместо этого, установленные и стратегические бизнес-правила используются поверх (и параллельно) прогнозной оценки для обеспечения справедливости и удовлетворенности клиентов. Будущая работа будет сосредоточена на стресс-тестировании наших глубоких последовательных моделей и зондировании результатов прогнозирования, чтобы определить, существуют ли субпопуляции владельцев карт, для которых наш новый подход работает лучше, чем эталонный. Важно также отметить, что наши данные были собраны в относительно стабильный экономический период, который не включал в себя никаких серьезных рецессий. По мере того как будут собираться все больше данных, мы сможем проверить устойчивость и способность к обобщению нашего подхода. Ссылки[1] Peter Martey Addo, Dominique Guegan, and Bertrand Hassani. 2018. Credit risk analysis using machine and deep learning models. Risks 6, 2 (2018), 38. https://doi.org/10.3390/risks6020038 [2] Sercan O. Arik and Tomas Pfister. 2019. TabNet: Attentive Interpretable Tabular Learning. (2019). arXiv:1908.07442 [3] Dmitrii Babaev, Alexander Tuzhilin, Maxim Savchenko, and Dmitrii Umerenkov. E.T.-Rnn: Applying deep learning to credit loan applications. In Proceedings of the ACM SIGKDD International Conference on Knowledge Discovery and Data Mining. 2183–2190. https://doi.org/10.1145/3292500.3330693[4] Shaojie Bai, J. Zico Kolter, and Vladlen Koltun. 2018. An Empirical Evaluation of Generic Convolutional and Recurrent Networks for Sequence Modeling. (2018). arXiv:1803.01271 [5] George EP Box and David R Cox. 1964. An analysis of transformations. Journal of the Royal Statistical Society: Series B (Methodological) 26, 2 (1964), 211–243. [6] Tianqi Chen and Carlos Guestrin. 2016. Xgboost: A scalable tree boosting system. In Proceedings of the 22nd ACM SIGKDD Unternational Conference on Knowledge Discovery and Data Mining. 785–794. [7] Yann N Dauphin, Angela Fan, Michael Auli, and David Grangier. 2017. Language modeling with gated convolutional networks. In Proceedings of the 34th International Conference on Machine Learning. 933–941. [8] Ian Dewancker, Michael McCourt, and Scott Clark. 2015. Bayesian Optimization Primer. [9] Dmitry Efimov, Di Xu, Alexey Nefedov, and Archana Anandakrishnan. 2019. Using Generative Adversarial Networks to Synthesize Artificial Financial Datasets. In 33rd Conference on Neural Information Processing Systems, Workshop on Robust AI in Financial Services. [10] Jerome H. Friedman. 2001. Greedy function approximation: A gradient boosting machine. Annals of Statistics 29, 5 (2001), 1189–1232. https://doi.org/10.2307/ 2699986 [11] Jonas Gehring, Michael Auli, David Grangier, Denis Yarats, and Yann N Dauphin. Convolutional sequence to sequence learning. In Proceedings of the 34th International Conference on Machine Learning. 1243–1252. [12] Kaiming He, Xiangyu Zhang, Shaoqing Ren, and Jian Sun. 2016. Identity mappings in deep residual networks, Vol. 9908 LNCS. Springer Verlag, 630–645. https://doi.org/10.1007/978-3-319-46493-0_38 arXiv:1603.05027[13] Geoffrey E Hinton, Nitish Srivastava, Alex Krizhevsky, Ilya Sutskever, and Ruslan R Salakhutdinov. 2012. Improving neural networks by preventing coadaptation of feature detectors. arXiv:1207.0580 (2012). [14] Sepp Hochreiter and Jürgen Schmidhuber. 1997. Long Short-Term Memory. Neural Computation 9, 8 (1997), 1735–1780. https://doi.org/10.1162/neco.1997.9. 8.1735 [15] Nal Kalchbrenner, Lasse Espeholt, Karen Simonyan, Aaron van den Oord, Alex Graves, and Koray Kavukcuoglu. 2016. Neural machine translation in linear time. arXiv preprint arXiv:1610.10099 (2016). [16] Diederik P Kingma and Jimmy Ba. 2014. Adam: A method for stochastic optimization. arXiv preprint arXiv:1412.6980 (2014). [17] David Krueger, Tegan Maharaj, János Kramár, Mohammad Pezeshki, Nicolas Ballas, Nan Rosemary Ke, Anirudh Goyal, Yoshua Bengio, Aaron Courville, and Chris Pal. 2017. Zoneout: Regularizing rnns by randomly preserving hidden activations. In Proceedings of the 5th International Conference on Learning Representations. arXiv:1606.01305 [18] Christopher D Manning, Prabhakar Raghavan, and Hinrich Schütze. 2008. Introduction to information retrieval. Cambridge University Press. 234–265 pages. [19] Loris Nanni and Alessandra Lumini. 2009. An experimental comparison of ensemble of classifiers for bankruptcy prediction and credit scoring. Expert Systems with Applications 36, 2 (2009), 3028–3033. https://doi.org/10.1016/j.eswa. 2008.01.018 [20] Aaron van den Oord, Sander Dieleman, Heiga Zen, Karen Simonyan, Oriol Vinyals, Alex Graves, Nal Kalchbrenner, Andrew Senior, and Koray Kavukcuoglu. Wavenet: A generative model for raw audio. arXiv preprint arXiv:1609.03499 (2016). [21] Razvan Pascanu, Tomas Mikolov, and Yoshua Bengio. 2013. On the difficulty of training recurrent neural networks. In Proceedings of the 30th International Conference on Machine Learning. 1310–1318. [22] Lutz Prechelt. 1998. Early stopping-but when? In Neural Networks: Tricks of the trade. Springer, 55–69. [23] Abhimanyu Roy, Jingyi Sun, Robert Mahoney, Loreto Alonzi, Stephen Adams, and Peter Beling. 2018. Deep learning detecting fraud in credit card transactions. In Proceedings of the Systems and Information Engineering Design Symposium,129–134. https://doi.org/10.1109/SIEDS.2018.8374722 [24] Lyn C Thomas, David B Edelman, and Jonathan N Crook. 2002. Credit scoring and its applications. SIAM. [25] Alex Waibel, Toshiyuki Hanazawa, Geoffrey Hinton, Kiyohiro Shikano, and Kevin J Lang. 1989. Phoneme recognition using time-delay neural networks. IEEE transactions on acoustics, speech, and signal processing 37, 3 (1989), 328–339. [26] Chongren Wang, Dongmei Han, Qigang Liu, and Suyuan Luo. 2018. A deep learning approach for credit scoring of Peer-to-Peer lending using attention mechanism LSTM. IEEE Access 7 (2018), 2161–2168. [27] Fisher Yu and Vladlen Koltun. 2016. Multi-scale context aggregation by dilated convolutions. In Proceedings of the 4th International Conference on Learning Representations. arXiv:1511.07122 =========== Источник: habr.com =========== =========== Автор оригинала: Jillian M. Clements, Di Xu, Nooshin Yousef, Dmitry Efimov ===========Похожие новости:

Машинное обучение ) |

|

Вы не можете начинать темы

Вы не можете отвечать на сообщения

Вы не можете редактировать свои сообщения

Вы не можете удалять свои сообщения

Вы не можете голосовать в опросах

Вы не можете прикреплять файлы к сообщениям

Вы не можете скачивать файлы

Вы не можете отвечать на сообщения

Вы не можете редактировать свои сообщения

Вы не можете удалять свои сообщения

Вы не можете голосовать в опросах

Вы не можете прикреплять файлы к сообщениям

Вы не можете скачивать файлы

Текущее время: 15-Янв 13:12

Часовой пояс: UTC + 5